Medidor de energia con Arduino

Con un arduino o equivalente podemos construir facilmente un watimetro o medidor de energia. Si la placa dispone de un escudo de lector de de trajetas o escudo wifi ademas podremos mejorar las prestaciones

Con un arduino o equivalente podemos construir facilmente un watimetro o medidor de energia. Si la placa dispone de un escudo de lector de de trajetas o escudo wifi ademas podremos mejorar las prestaciones

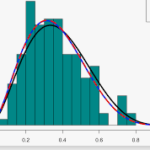

Usaremos en este post la Estimación de máxima verosimilitud para estimar los parámetros de un modelo de Poisson.

statsmodelscontiene otros modelos de probabilidad integrados como Probit y Logit .

Para mayor flexibilidad, statsmodelsproporciona una forma de especificar la distribución manualmente utilizando la GenericLikelihoodModelclase; aquí se puede encontrar un cuaderno de ejemplo .