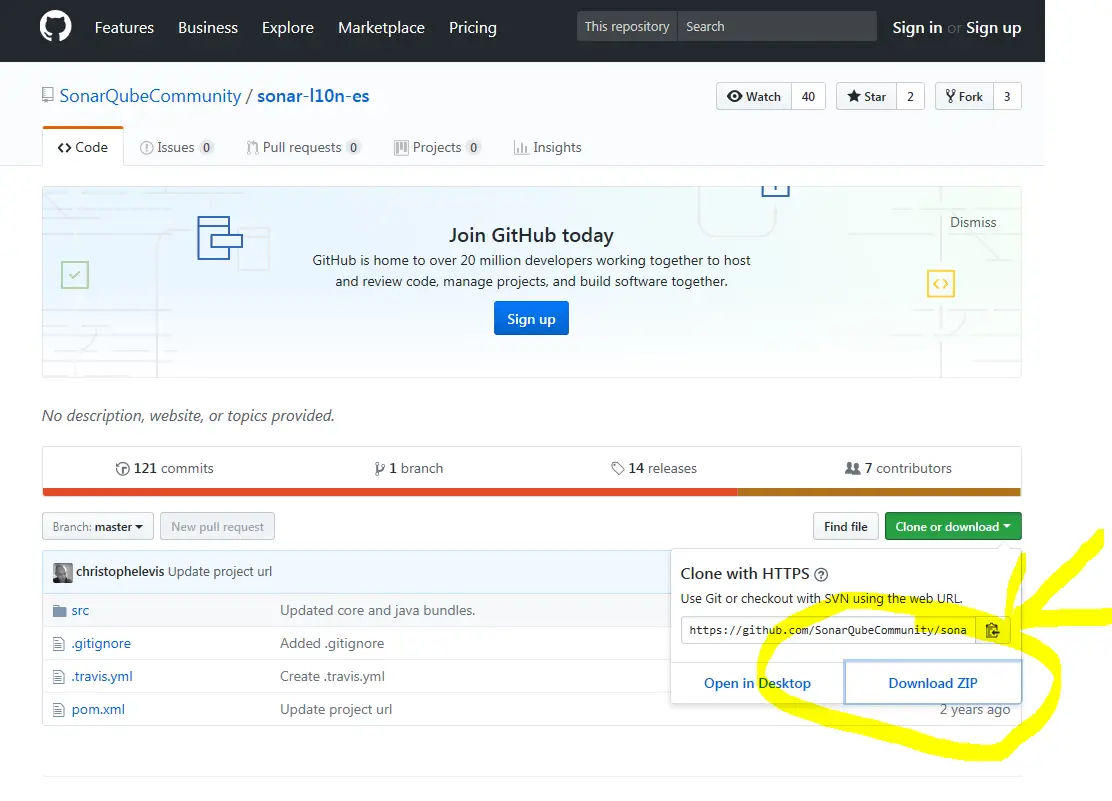

Que no le vendan gato por liebre con las unidades flash USB y los SSD

Al evaluar un dispositivo de almacenamiento, tomamos en cuenta principalmente tres factores: la capacidad, la velocidad y, evidentemente, el precio. Si al menos dos de estos elementos satisfacen o exceden nuestras expectativas, entonces consideramos que es una opción de compra acertada. Comercios como AliExpress ofrecen una extensa variedad de discos SSD, tarjetas SD y memorias USB con capacidades significativas a precios competitivos. Estos artículos se comercializan masivamente cada día, lo que atrae a numerosos consumidores que, sin darse cuenta, podrían ser víctimas de un fraude.