Introducción a python científico

Introducción al Python científico (numpy, matplotlib y pandas)

Introducción al Python científico (numpy, matplotlib y pandas)

Terraform es un software de infraestructura como código desarrollado por HashiCorp con filosofia abierta permitiendo a los usuarios definir y configurar la infraestructura de un centro de datos en un lenguaje de alto nivel

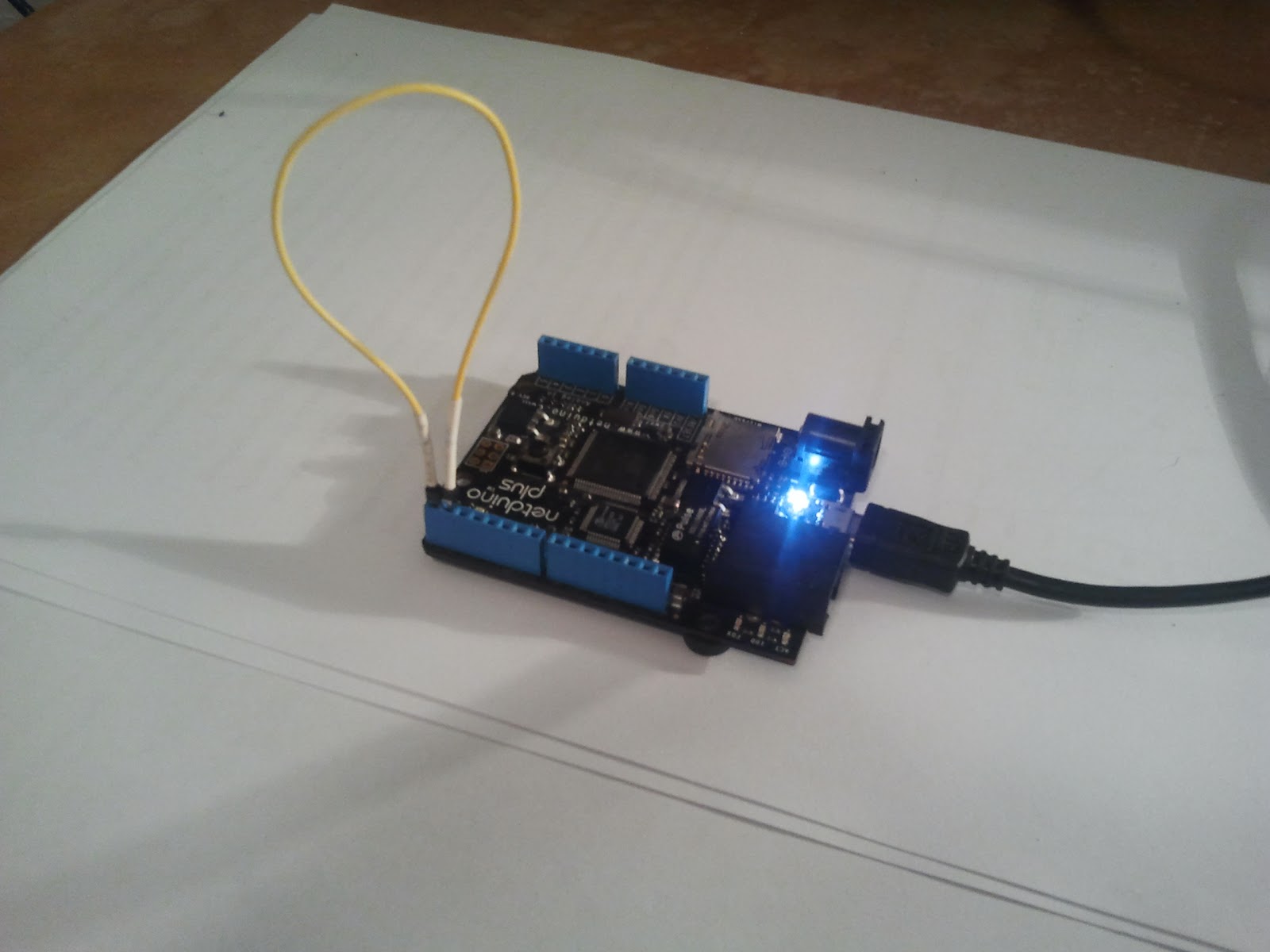

Wilderness Labs, encabezado por un ex ejecutivo de Xamarin, anunció ya en 2018 una plataforma de IoT dirigida a desarrolladores empresariales y profesionales que ejecuta aplicaciones completas de .NET Standard en un microcontrolador. Es seguro desde cero, admite actualizaciones por aire y está diseñado específicamente para ejecutar tareas de IA en el campo. Dirigido a desarrolladores profesionales, busca hacer que la construcción de cosas conectadas sea tan fácil como el desarrollo web o móvil. Podría considerarse una evolución de Netduino, pero es mucho mas como aunque su futuro aun esta por dilucidar.

Una guía para construir la configuración de RetroPie en Ubuntu (16.04 LTS o posterior) x86 y distribuciones basadas en Debian.