«Publicar o perecer» es una frase muy utilizada en el mundo académico para subrayar la presión a la que se ven sometidos los investigadores para publicar continuamente sus trabajos con el fin de asegurarse el empleo, la financiación y la promoción profesional. Destaca la naturaleza competitiva de los entornos académicos, en los que la productividad y la producción de publicaciones son métricas cruciales para el éxito. La frase subraya la idea de que no publicar con regularidad puede obstaculizar la carrera académica.

Con la idea en mente esta disponible una herramienta informática diseñada para ayudar a los investigadores académicos a evaluar su impacto en el ámbito académico a través de métricas como citas, índices h, índices g y otros indicadores de productividad académica. Este programa recopila y analiza datos de citas de diferentes bases de datos académicas, como Google Scholar, para proporcionar métricas útiles sobre la influencia y el alcance de las publicaciones de un investigador. Es una herramienta popular entre los académicos para evaluar su desempeño y su impacto en la comunidad científica.

Veamos unas simples Instrucciones detalladas sobre cómo descargar e instalar Publish or Perish para Windows y como usarlo.

Nota: El instalador del software Publish or Perish NO requiere derechos de administrador. Puede instalar el software Publish or Perish en su ordenador de escritorio o portátil incluso como un usuario sin privilegios.

Publish or Perish se proporciona por cortesía de Harzing.com. Es gratis para uso personal sin fines de lucro; consulte el Acuerdo de licencia de usuario final para conocer los términos y condiciones completos de la licencia.

Requisitos del sistema

Verifique que su ordenador cumpla con los siguientes requisitos mínimos del sistema:

- Windows 7, 8, 8.1, 10 y 11, incluidas las ediciones x64 y Server.

- Algo de memoria (suficiente para ejecutar el sistema operativo, no mucho más).

- Algo de espacio en el disco duro (ídem).

- Una conexión a Internet.

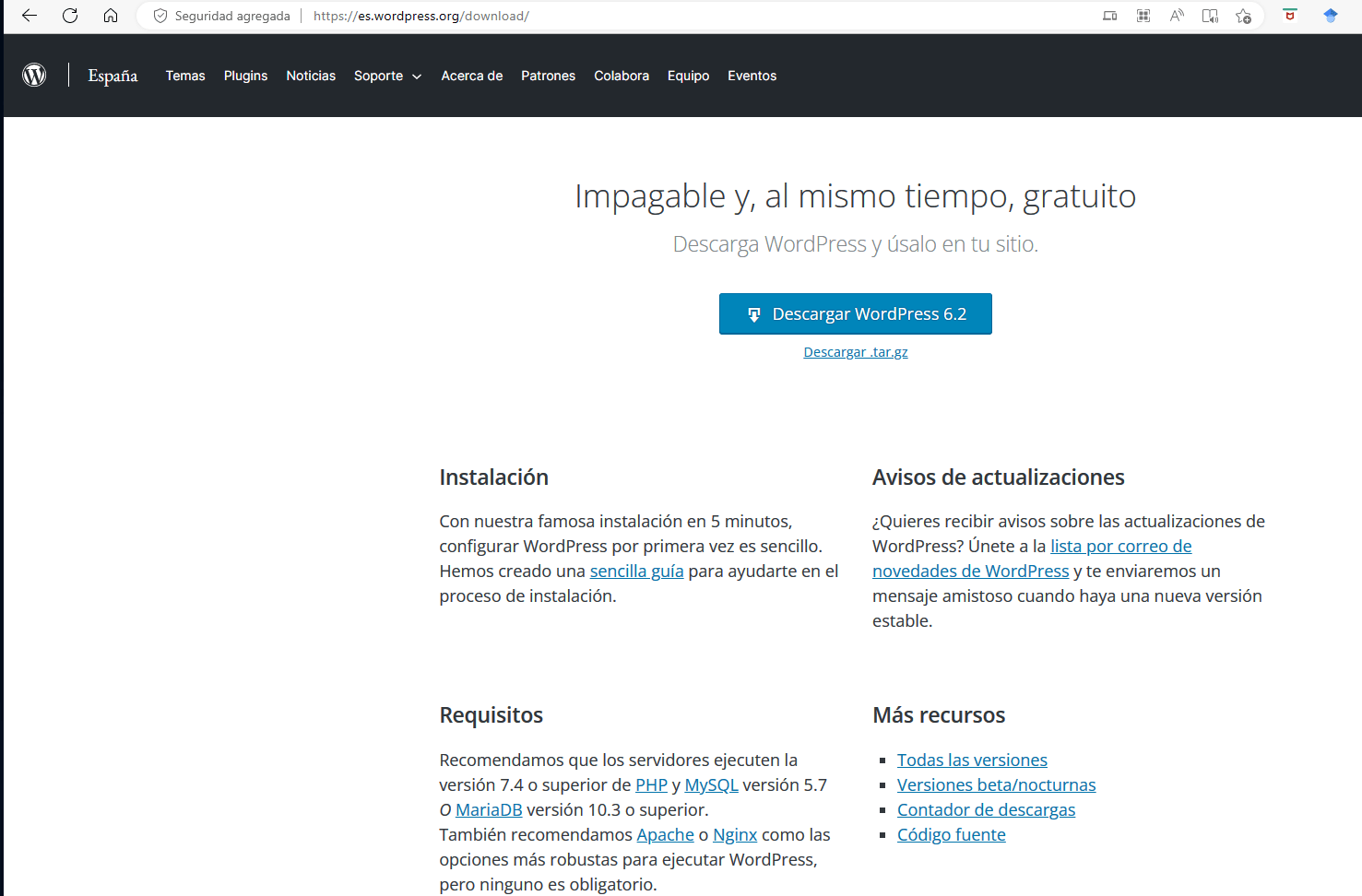

Descargar información

Descargue el instalador del software Publish or Perish del sitio web Harzing.com:

![]() Instalador de Publish or Perish para Windows (2.9 MB)

Instalador de Publish or Perish para Windows (2.9 MB)

Versión: 8.8.4384 (6 de mayo de 2023) [Cambios en esta versión]

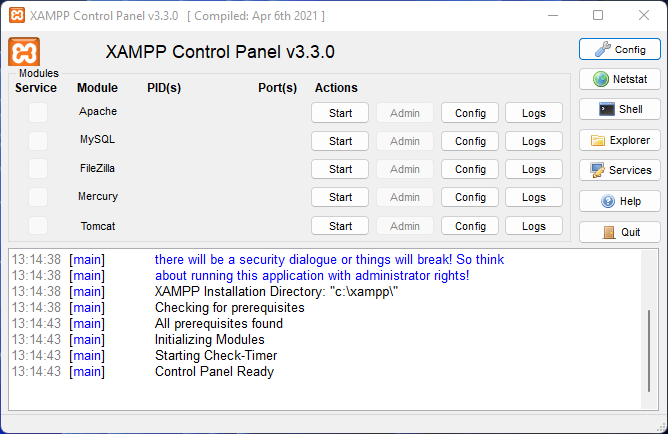

Instrucciones de instalación

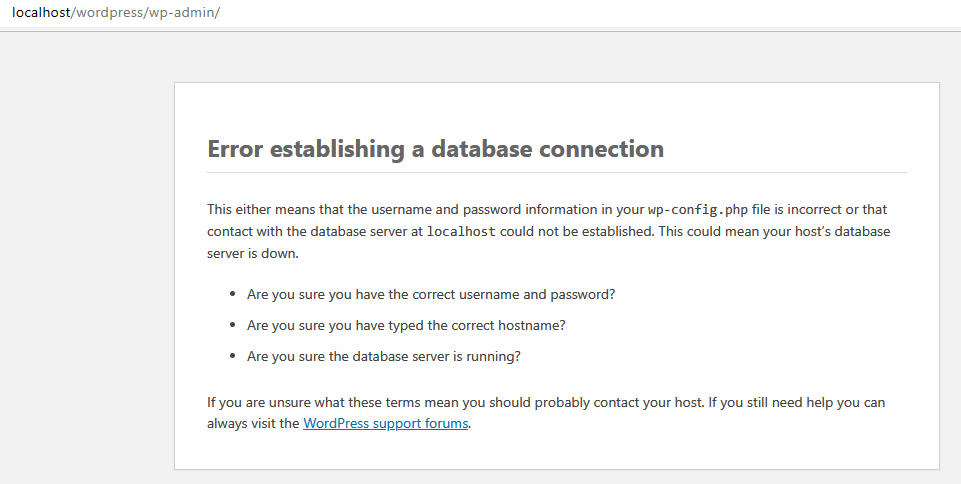

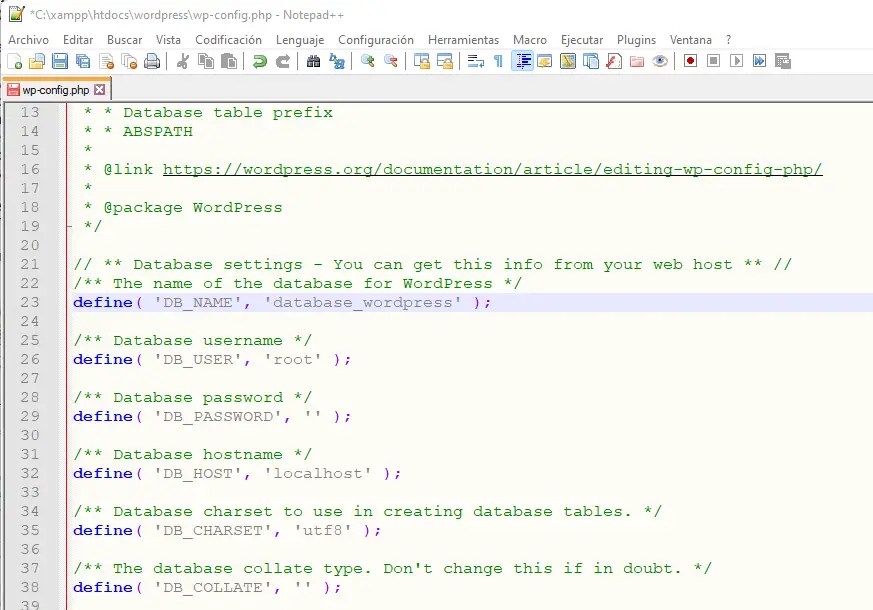

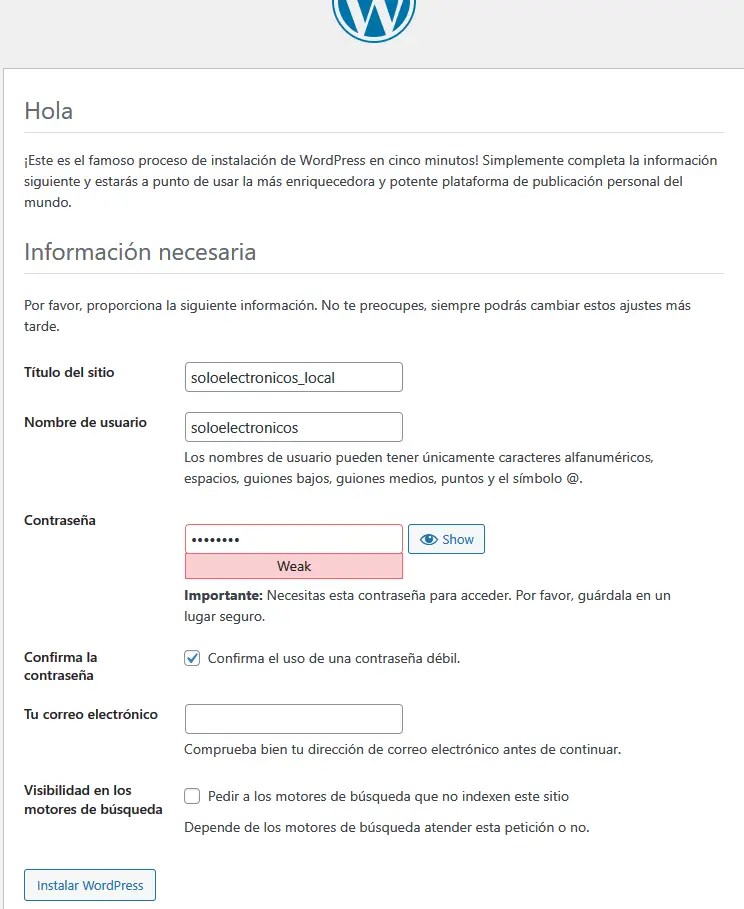

Inicie el instalador de PoP8Setup.exe haciendo doble clic en el archivo que acaba de descargar. En la mayoría de los sistemas, ahora aparecerá un cuadro de diálogo de advertencia de seguridad similar a uno de los siguientes.

Windows 10 (actualización 1607 y posterior):

Windows 10 (original) y Windows 8.x:

Windows 7:

Haga clic en Ejecutar , Continuar o Sí después de haber verificado que el nombre del editor es Tarma Software Research Ltd.

(Nota: antes del 15 de agosto de 2014, nuestros instaladores estaban firmados por Tarma Software Research Pty Ltd ; estos también están bien).

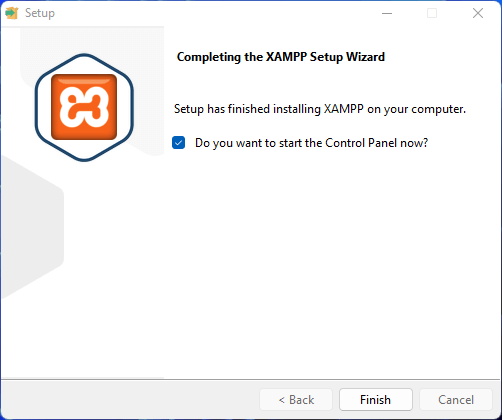

Ahora se iniciará el instalador. Siga las instrucciones en pantalla para confirmar su aceptación del acuerdo de licencia e instalar el software Publish or Perish en su computadora.

Nota: si tiene una versión anterior de Publish or Perish en su ordenador, se eliminará automáticamente antes de que se instale la nueva versión. Sus consultas se conservan durante el proceso de actualización.

Una vez completada la instalación, puede iniciar Publish or Perish a través del menú Inicio de Windows: haga clic en el botón del menú Inicio , luego en Todos los programas y luego en Publish or Perish 7 .

Si alguna vez necesita eliminar el software Publish or Perish de su sistema, use el panel de control Agregar o quitar programas.

USO HABITUAL

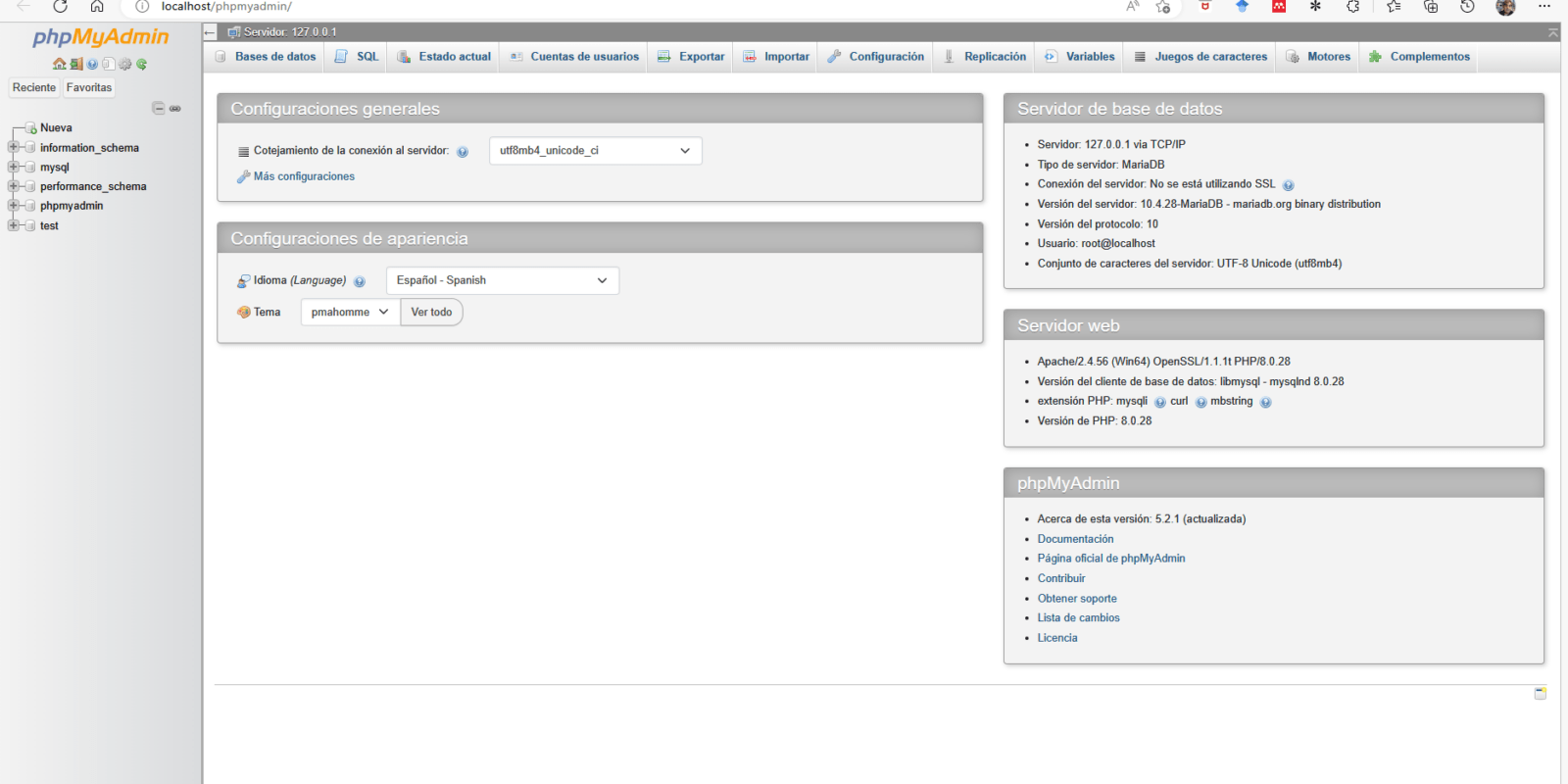

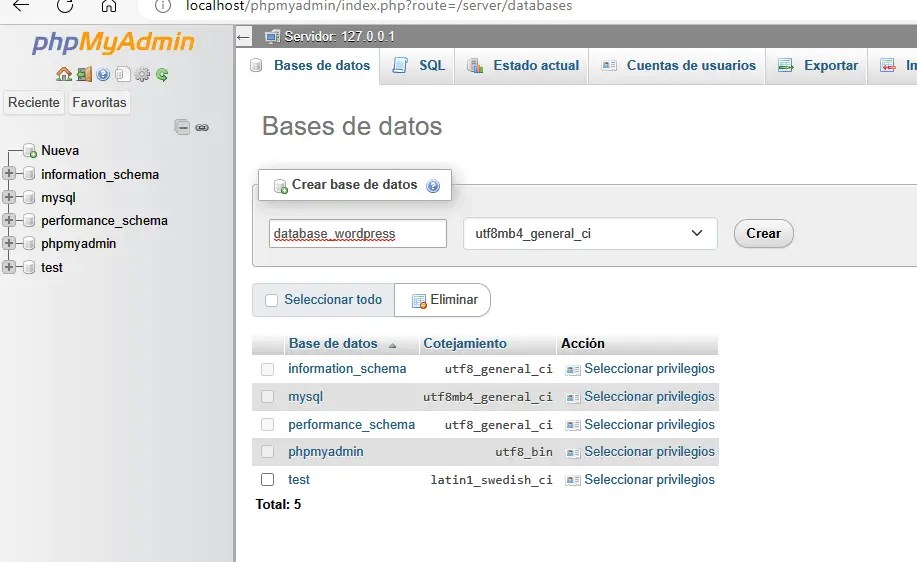

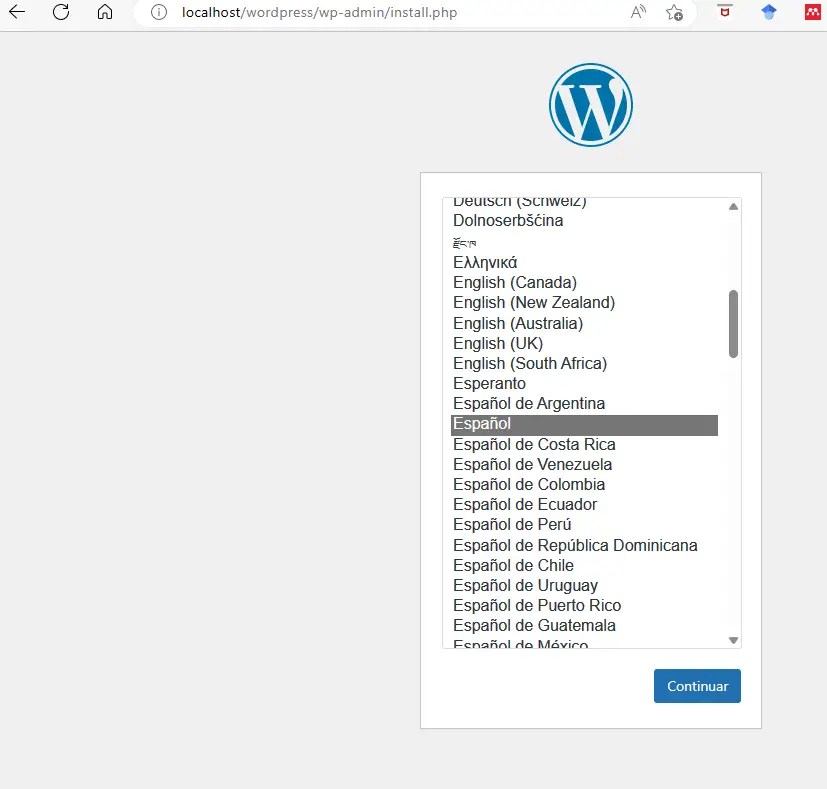

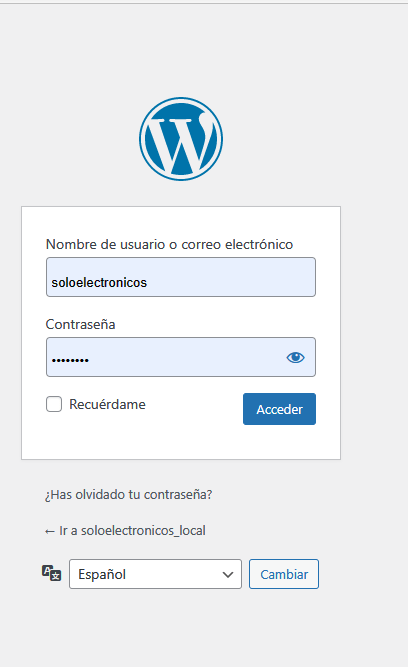

- Ejecución del programa: Después de instalarlo, abra el programa «Publish or Perish».

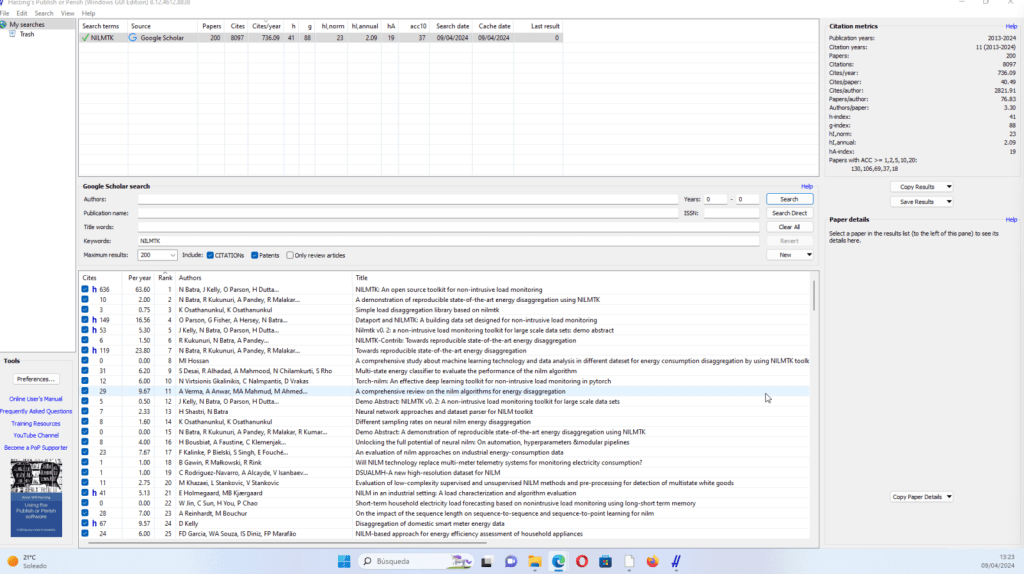

- Búsqueda de autor o término: En la barra de búsqueda, ingrese el nombre del autor cuyo impacto deseas evaluar o ingresa un término para buscar trabajos relevantes. Puede ajustar la búsqueda mediante diferentes opciones, como el rango de años o las bases de datos a utilizar.

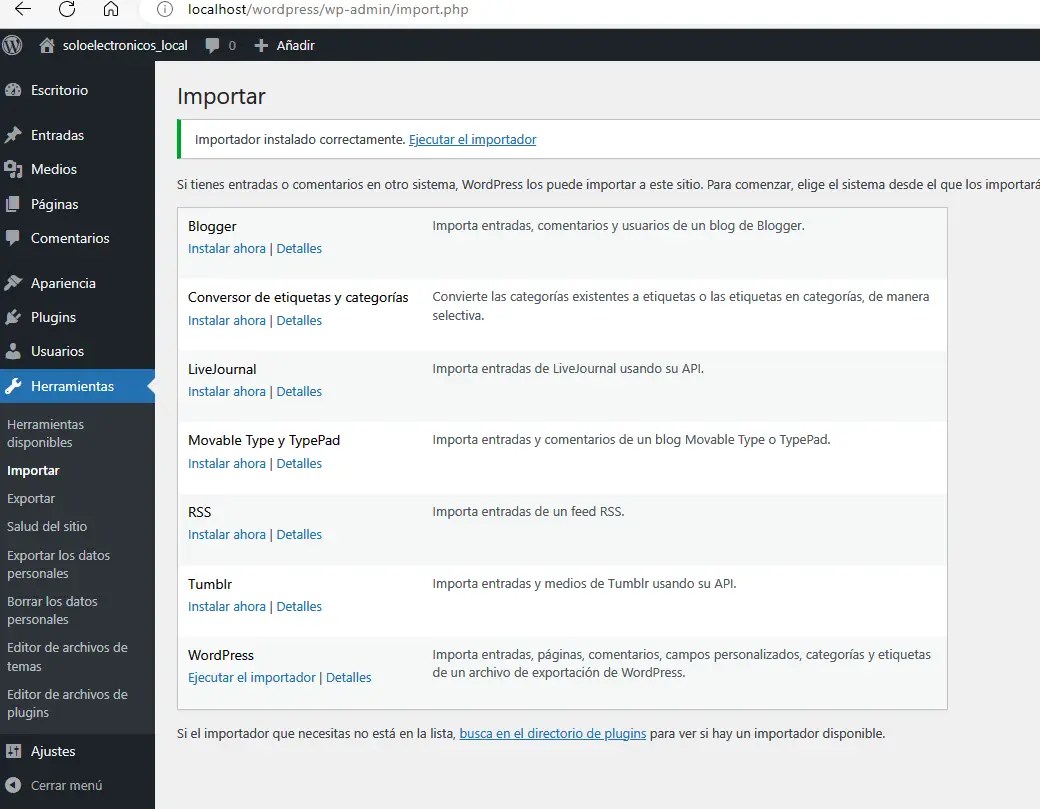

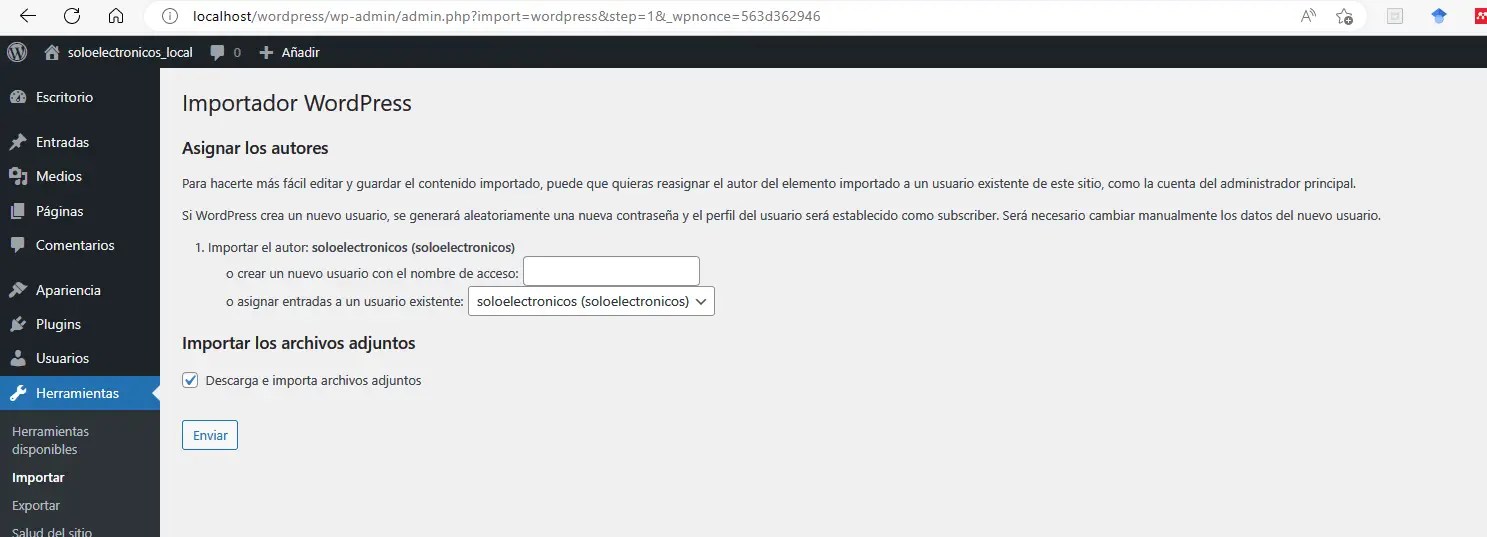

- Análisis de resultados: Una vez que se complete la búsqueda, «Publish or Perish» mostrará una lista de resultados relevantes. Puede explorar estos resultados para obtener información detallada sobre las citas, el índice h, el índice g y otras métricas de impacto académico.

- Refinar y exportar resultados: Puede refinar aún más los resultados utilizando filtros o ajustes adicionales. Además, puede exportar los resultados en diferentes formatos para su posterior análisis o referencia.

Como ejemplo para buscar bibliografia sobre NILMTK ( toolkit abierto para el nilm del que hemos hablado en este blog) podemos hacerlo simplemente buscando el término pulsando en Search->New Google Scholar Search y en Keywords escribimos NILMK.

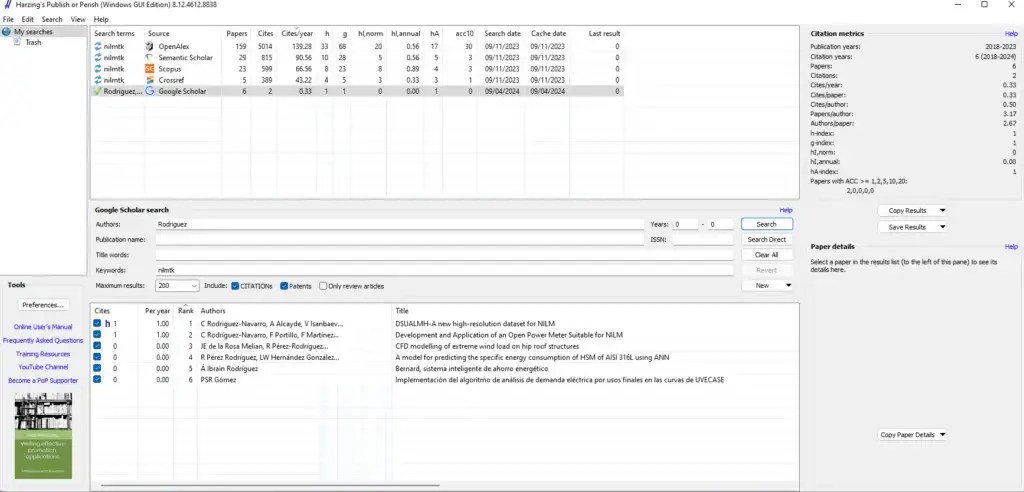

También podemos buscar en OPenAlex, PubMed, Scopus, web of science , etc

Asimismo podemos refinar la búsqueda por otros criterios, como por ejemplo el autor.

Por ultimo no olvide que podemos acceder directamente al documento pulsando en cada enlace

Recuerde que «Publish or Perish» utiliza datos de citas académicas, por lo que la precisión de los resultados puede variar dependiendo de la disponibilidad y precisión de los datos de las bases de datos académicas utilizadas. Además, tenga en cuenta que esta herramienta es una ayuda para la evaluación del impacto académico y no debe considerarse como la única medida de la calidad de la investigación.

Debe estar conectado para enviar un comentario.