La versión original B de la Raspberry Pi Modelo A y B era una computadora de una tarjeta individual de $ 35 con un conector de entrada / salida de uso general (GPIO) de 26 pines !y esto lleva un conjunto de señales y buses!. Hay 8 pines de E / S digitales de uso general – estos pueden ser programados como salidas digitales o entradas. Dos de estos pines (en Pi de 40 pines, sólo uno de 26 pines Pi) se puede designar para la salida de hardware PWM también. Además, hay una interfaz I2C de 2 hilos y una interfaz SPI de 4 hilos (con una segunda línea de selección, lo que hace 5 pines en total) y el UART serie con otros 2 pines.

A lo largo de los años ha habido algunas actualizaciones:

- El modelo B, Revisión 1.1 Raspberry Pi tiene un adicional de 4 líneas GPIO en un conector separado que tiene que soldar en el tablero.

- El modelo A + y B + Raspberry Pi’s representa 2 años de investigación, desarrollo y pruebas y cuenta con un solo conector GPIO de 40 pines con 28 clavijas GPIO utilizables y 4 tomas USB.

- El modelo 2 cuenta con un procesador quad-core Arm A7 con 1 GB de RAM. Mismo GPIO.

- El modelo Zero es un corte de Pi A + (1GHz). 40-pines GPIO conector y muy poco más. En efecto en 2015 la Fundación Raspberry Pi lanzaba la Zero, un modelo que destaca por ser baratísimo – del orden de 5 dólares – más compacto, con menos componentes y también menor oferta de puertos. En este caso para conectarla a internet podremos emplear su puerto Ethernet o enchufarle un dongle USB para el Wi-Fi. Dos años después se lanzaba la Zero W (10,53 euros), que seguía la estela de precios bajos – 10 dólares – pero implementaba Wi-Fi y Bluetooth, una novedad de lo más útil para usarla en proyectos. Para paliar uno de esos problemas inherentes a su sencilla propuesta disponemos de la Raspberry Pi Zero WH (14,60 euros), que en este caso lleva los pines GPIO presoldados. Si se es principiante, mejor apostar por otros modelos ya que pese a su bajo coste y reducidas dimensiones, es un modelo básico, adolece de puertos USB estándar y como hemos visto, en algunos casos no incluye pines GPIO, lo que en la práctica se traduce en tener que soldar los pines y tener que emplear un adaptador microUSB-USB. No es ni mucho menos el modelo más rápido, pero resulta particularmente útil para proyectos que conllevan iluminación, motores o cámaras.

- El modelo 3 cuenta con un procesador quad-core Arm A8 (64 bits) con la misma RAM y GPIO que el modelo 2, sin embargo también cuenta con Wi-Fi y Bluetooth. Aún el mismo precio de $ 35.Las interfaces I2C, SPI y UART también se pueden utilizar como pines de E / S de uso general cuando no se usan en sus modos de bus, dando un total de 8 + 2 + 5 + 2 = 17 pines E / S en el conector P1 Además de 4 más en el conector P5 en un Revision 2 Pi) y 28 pines E / S en las tarjetas B + y 2 y 3 (aunque 2 se reservan para la interfaz HAT I2C, pero se pueden utilizar como GPIOs normales si no se utiliza un Tablero.

- El modelo 4B es la última y más potente de las Rpi y llega con avances que los usuarios agradecemos mucho. El primero es su mayor rendimiento, gracias a las especificaciones de su procesador y sus opciones de memoria de acceso aleatorio, llegando incluso a los 8GB. Gracias a este salto puede emplearse para aplicaciones más exigentes en RAM como puede ser el formato de ordenador de escritorio o como servidor. La segunda gran novedad tiene que ver con el abanico de opciones que ofrecen sus puertos. Así, cuenta con una oferta de puertos USB 3.0 y 2.0 donde las generaciones anteriores se quedaban en el estándar antiguo, un estándar que ofrece una mayor transferencia de datos.

WiringPi es una biblioteca bajo la licencia LGPLv3 de GNU de acceso GPIO basada en PIN escrita en C para el BCM2835 utilizado en la RP . Es utilizable desde C, C ++ y RTB (BASIC), así como muchos otros lenguajes con envolturas adecuadas Está diseñado para ser familiar a las personas que han usado el sistema de » cableado » de Arduino

WiringPi incluye una utilidad de línea de comandos gpio que se puede utilizar para programar y configurar los pines GPIO. Tambine puede usarse para leer y escribir los pines e incluso utilizarlo para controlarlos desde scripts de shell.

WiringPi es extensible y se proporcionan módulos para extender el cableado Pi para usar dispositivos de interfaz analógica en el Gertboard y para usar los populares chips de expansión GPIO MCP23x17 / MCP23x08 (I2C 7 SPI), así como módulos que permitirá bloques de hasta 4 × 74 × 595 para ser encadenados juntos por un valor adicional de 32 bits de salida como una sola unidad. (Usted puede tener varios bloques de 4 74x595s si es necesario)

Además, puede escribir fácilmente sus propios módulos de expansión para integrar sus propios dispositivos periféricos con el cableadoPi según sea necesario.

WiringPi soporta lectura analógica y escritura, y aunque no hay hardware analógico nativo en un Pi por defecto, se proporcionan módulos para soportar los chips analógicos Gertboards y otros dispositivos A / D y D / A se pueden implementar con relativa facilidad.

Adicionalmente , devLib es un conjunto de rutinas de la biblioteca implementadas usando wiringPi para darle acceso fácil a algunos periféricos populares. Los dispositivos soportados incluyen pantallas LCD de caracteres (basadas en los chips Hitachi HD44780U) y gráficas – por ejemplo, las pantallas comunes de 128 × 64 píxeles con el chip 12864H genérico. El chip de reloj DS1302 RTC, sensores basados en los chips Maxdetect (por ejemplo, RHT003), las tarjetas de interfaz Gertboard y PiFace y así sucesivamente.

PINES

La numeración de pines de los puertos GPIO en la Raspberry Pi ha sido una fuente de gran confusión desde que los diseños para el Pi fueron publicados por primera vez. En los primeros días (incluso antes de que el hardware estuviera disponible) los pines GPIO utilizables por defecto se denominaban simplemente por número como GPIO0 a GPIO7. Además hubo pines para otros fines como SPI, I2C y serial, pero esto no es diferente a cómo funciona el Arduino ( por ejemplo el Pin 13 en el Arduino es el puerto B, bit 5, por ejemplo).

Resumidamente pues las definiciones de hardware subyacentes se ocultan mediante un esquema de numeración simplificado. En el Pi, usando el cableadoPi , el pin 0 es BCM_GPIO pin 17 por ejemplo)

Sin embargo esto se ha visto posteriormente como «incorrecto» y varias personas han expresado su preocupación por este esquema de numeración, . Y ha demostrado su valía sobre las revisiones de la placa del hardware donde algunos pines cambiaron sus definiciones del hardware, aunque aun asi wiringPi podía ocultar esto al usuario. Como resultado (por ejemplo), un programa que utiliza el cableadoPi pin 2 en un Rev. 1 Pi funcionará sin cambios en un Rev 2. Pi, sin embargo alguien que use BCM_GPIO pin 21 en un Rev 1 Pi tendrá que cambiar su programa para usar BCM_GPIO Pin 27 en una Rev 2.

Así que wiringPi soporta su propio esquema de numeración de pines, así como el esquema de numeración de pin BCM_GPIO. Ya a partir de la versión 2, también soporta los números de pines de hardware físico (para el conector P1 solamente), pero es interesante sugerir que se adhiera a la simplificación WiringPi número de pin. De esta manera sus programas serán portátiles a través de diferentes revisiones de hardware sin necesidad de cambios.

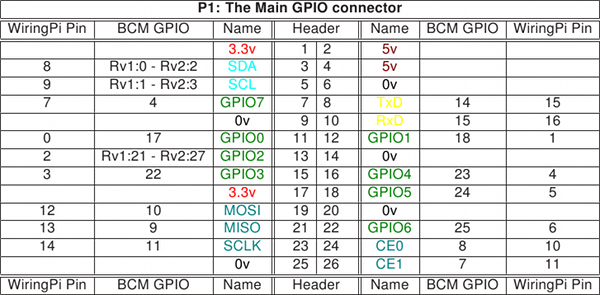

Las siguientes tablas proporcionan la asignación de los pines GPIO en la Raspberry Pi al conector GPIO (P1) en relación con los números de pin y la ubicación física en el conector. Esta es una representación del conector GPIO como se ve mirando la placa desde arriba. El conector GPIO se encuentra en la parte superior derecha de la placa con los conectores Ethernet y USB en la parte inferior.

Gpio1 revisiones del tablero

Observe por favor las diferencias entre las revisiones 1 y 2 de la tarjeta (Rv1 y Rv2 arriba) La revisión 2 es fácilmente identificable por la presencia de los 2 agujeros de montaje.

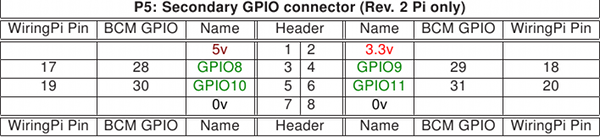

Gpio2

El conector P5 está diseñado para tener el cabezal soldado en la parte inferior de la placa. El pin 1 se identifica mediante la almohadilla de soldadura cuadrada. Así que si usted suelda el encabezado en la parte superior de la placa tenga en cuenta que las ubicaciones de pin será el contrario!

Desde los conectores GPIO de 26 pines, un nuevo conector de 40 pines ha aparecido en los nuevos Pi’s. También hay las tarjetas de módulo de cálculo. La mejor manera de obtener una descripción del conector GPIO en cualquier Pi que esté ejecutando actualmente es usar el comando gpio:

$ gpio readall

Esto le dará una imagen completa de los conectores GPIO de Pi con todos los esquemas de numeración presentes.

UTILIDAD GPIO

WiringPi viene con un programa separado para ayudar a administrar el GPIO. Este programa, llamado gpio , también se puede usar en scripts para manipular los pines GPIO – establecer salidas y entradas de lectura. Incluso es posible escribir programas enteros usando el comando gpio en una shell-script, aunque no es muy eficiente hacerlo de esa manera . Otra forma de llamarla es usando la función system () en C / C ++ o es equivalente en otra programación Idiomas.

El comando gpio está diseñado para ser instalado como un programa setuid y llamado por un usuario normal sin usar el comando sudo (o iniciar sesión como root).

Además de utilizar la utilidad gpio para controlar los pines GPIO, puede:

- Export / Unexport a través de la interfaz / sys / class / gpio , donde luego estarán disponibles para los programas de usuario (que luego no necesitan ser ejecutados como root o con sudo)

- Exportar pines para activar las interrupciones activadas por el borde a través de la interfaz / sys / class / gpio .

- Controlar los pines del dispositivo periférico PiFace .

- Cargar módulos SPI e I2C y establezca / dev / permisos para permitir la lectura / escritura por el usuario que ejecuta el programa gpio .

- Ajustar el tamaño del búfer SPI y la velocidad en baudios I2C (al cargar los módulos)

Valores de salida al DAC de Gertboard - Leer las entradas del Gertboard ADC

- Determinar su revisión del hardware de la tabla de Frambuesa Pi.

Vea la página de manual del programa gpio para ver lo que todas las características están escribiendo.

COMANDOS BASICOS

Home gpio

En el símbolo del sistema.

Uso

Desde la línea de comandos de Linux:

Gpio-v

Esto imprime la versión.

Gpio-g …

El indicador opcional -g hace que los números de pin sean interpretados como números de pin BCM_GPIO en lugar de números de pin estándar de cableadoPi .

Comandos de entrada y salida estándar

Modo gpio [-g] in / out / pwm / arriba / abajo / tri

Esto establece el modo de un pin para ser entrada, salida o pwm y, además, puede configurar las resistencias pull-up / down para pull-up, pull-down o none.

Gpio [-g] escribe 0/1

Esto establece un pin de salida a alto (1) o bajo (0)

Gpio [-g] pwm

Ajuste el pin a un valor PWM (se admite 0-1023)

Gpio [-g] read

Lee e imprime el valor lógico del pin indicado. Se imprimirá 0 (bajo) o 1 (alto).

Gpio readall

Esto lee todos los pines normalmente accesibles e imprime una tabla de sus números (tanto wiringPi y BCM_GPIO, por lo que hace un gráfico de referencia cruzada útil), junto con sus modos y valores actuales.

Comandos de carga del módulo

Gpio load spi [tamaño del búfer en KB]

Esto carga los módulos del kernel SPI y, opcionalmente, establece el búfer interno en el tamaño dado en KB (múltiplos de 1024). El valor predeterminado es 4KB y suele ser más que suficiente para la mayoría de las aplicaciones que sólo cambian un byte o 2 a la vez por el bus SPI.

Las entradas / dev / spi * están configuradas para ser propiedad de la persona que utiliza el programa gpio , por lo que no hay necesidad de ejecutar programas posteriores como root (a menos que utilicen otras funciones wiringPi)

Gpio load i2c [velocidad de transmisión en Kb / s]

Esto carga los módulos del kernel I2C y, opcionalmente, establece la velocidad en baudios a la velocidad dada en Kb / seg (múltiplos de 1000). El valor predeterminado es 100Kb / seg.

Las entradas / dev / I2c * están configuradas para ser propiedad de la persona que usa el programa gpio , por lo que no hay necesidad de ejecutar programas posteriores como root (a menos que usen otras funciones wiringPi )

Comandos de modo / sys / class / gpio

Gpio export entrada / salida

Esto exporta el pin dado (número PIN de BCM-GPIO) como una entrada o salida y lo hace disponible para un programa de usuario que se ejecuta como el mismo usuario para usar.

Gpio unexport

Elimina la exportación del pin especificado.

Gpio unexportall

Elimina todas las exportaciones de / sys / class / gpio .

Export gpio

Esto imprime una lista de todos los pines gpio que se han exportado a través de la interfaz / sys / class / gpio y sus modos.

Gpio edge sube / baja / ambos / ninguno

Esto permite que el pin dado para la interrupción del borde dispare en el aumento, la caída o ambos bordes. (O ninguna que lo deshabilite)

Nota: Los números de pin en el modo sys siempre son números de pin BCM-GPIO.

Ejemplos

Gpio mode 0 out

Gpio write 0 1

Esto utiliza los números de pin del cableadoPi para establecer el pin 0 como una salida y luego establece el pin en una lógica 1.

Gpio -g mode 0 in

Gpio -g read 0

Esto utiliza el esquema de numeración de pines BCM_GPIO y lee el pin 0 (SDA0 en una Rev. 1 Raspberry Pi)

Resistencias de pulldown hacia arriba / abajo

Las líneas GPIO tienen resistencias pull up o pull-down internas que pueden ser controladas mediante software cuando un pin está en modo de entrada.

Gpio mode 0 up

Gpio mode 0 down

Modo gpio 0 tri

Estos fijan las resistencias para tirar hacia arriba, pull-down y ninguno respectivamente en el pin 0 del cableado .

Comandos PiFace

El PiFace es algo limitado en que tiene 8 pines de entradas y 8 pines de salida y estos se fijan en el hardware, por lo que sólo los comandos de escritura y lectura se implementan:

Gpio -p write 0/1

Escribe el valor 0 (desactivado) o 1 (activado) en el pin de salida del PiFace

Gpio -p read Lee e imprime el valor en el pin de entrada dado.

Gpio -p mode up / tri

Esto habilita (arriba) o desactiva (tri) la resistencia pull-up interna en el pin de entrada dado. Debe habilitar el pull-up si desea leer cualquiera de los interruptores de a bordo de la placa PiFace.

Mas información en http://wiringpi.com/

Debe estar conectado para enviar un comentario.