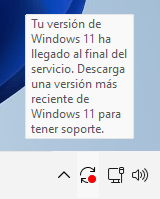

El mensaje de «Fin de servicio» en Windows 11 suele aparecer cuando tu versión de Windows ha llegado al final de su soporte y ya no recibe actualizaciones de seguridad. No es recomendable desactivarlo sin actualizar el sistema operativo, ya que eso puede poner en riesgo la seguridad de tu equipo. Desde luego lo ideal es intentar actualizarlo , aunque no siempre es posible sobre todo si el equipo no cuenta con el chip TPM.

Ciertamente el iconito con el punto rojo podemos olvidarnos pero a veces si no vamos a actualizar no gustaria ocultarlo ¿Por qué NO se puede quitar solo el mensaje? El mensaje está integrado en el sistema y no hay una opción oficial ni segura para eliminarlo. Modificar el registro o archivos del sistema para ocultarlo puede dañar Windows o bloquear futuras actualizaciones.El mensaje volverá a aparecer tras reinicios o futuras comprobaciones del sistema.Sin embargo, si comprendes los riesgos y aún así quieres ocultarlo, aquí tienes algunas opciones:

Opción 1: Usar el Editor del Registro (Regedit)

- Presiona

Win + R, escriberegedity presiona Enter. - Navega a la siguiente clave:

HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Microsoft\Windows\WindowsUpdateSi no existe, créala. - Dentro de esa clave, crea un nuevo valor

DWORD (32 bits)con el nombre:DisableOSUpgradeY asígnale el valor1. También puedes probar crear esta otra clave para bloquear notificaciones específicas:HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\WindowsUpdate\UX\SettingsEn esa clave, crea o modifica el valor:HideMCTLink = 1 (DWORD)

Reinicia tu PC después de hacer estos cambios.

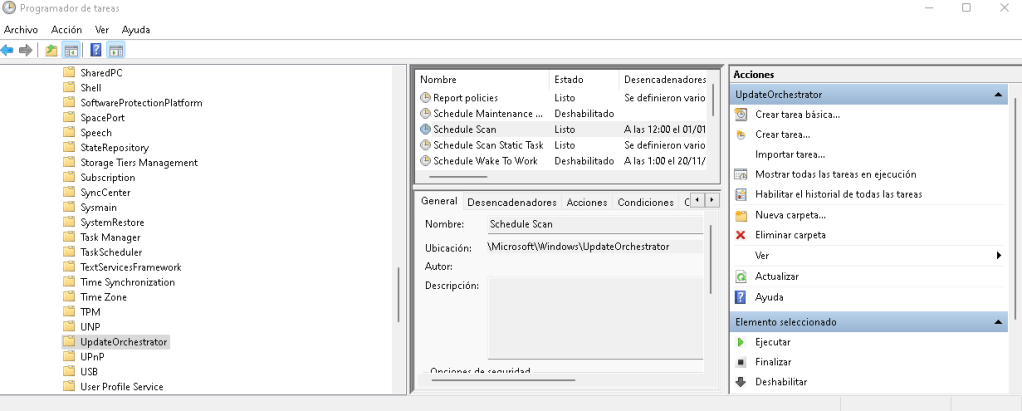

Opción 2: Usar el Programador de tareas

- Abre el Programador de tareas (

taskschd.msc). - Ve a:

Biblioteca del Programador de tareas > Microsoft > Windows > UpdateOrchestrator - Busca tareas como:

Schedule ScanUpdateModelTaskUSO_UxBroker← Esta puede generar notificaciones

- Haz clic derecho en cada una y selecciona «Deshabilitar».

Opción 3: Desactivar notificaciones en Configuración

Esto no elimina el mensaje, pero puede ocultar su aparición:

- Ve a Configuración > Sistema > Notificaciones.

- Desactiva «Notificaciones de Windows Update» o «Sugerencias y trucos».

Recomendación: Si estás recibiendo este mensaje, es señal de que tu versión de Windows 11 está obsoleta. Considera actualizar a una versión más reciente (como 23H2) para mantener la seguridad y soporte.

Lo ideal, es repito actualizar por lo que veamos las alternativas para Actualizar Windows 11 Sin Formatear:

1. Actualización con el Asistente de Instalación de Windows 11

- Descarga el Asistente de Instalación de Windows 11 desde la página oficial de Microsoft:

https://www.microsoft.com/es-es/software-download/windows11 - Ejecuta el asistente y sigue las instrucciones.

Selecciona la opción de conservar tus archivos y aplicaciones. - Deja que el proceso termine.

Si hay errores, toma nota del código o mensaje específico.

2. Actualizar con una ISO de Windows 11 (sin perder tus archivos)

- Descarga la ISO oficial de Windows 11 desde la misma página de Microsoft.

- Haz doble clic en el archivo ISO para montarlo como una unidad virtual.

- Ejecuta el archivo

setup.exedesde la unidad virtual. - Elige la opción “Conservar archivos y aplicaciones” cuando se te pregunte.

- Sigue el proceso de actualización.

Importante: Si el instalador te dice que no puedes conservar tus archivos, puede ser por:

- Tu versión actual es demasiado antigua.

- Hay incompatibilidades de idioma o edición (por ejemplo, Home vs Pro).

- Hay archivos dañados en el sistema.

3. Solucionar problemas antes de actualizar

- Ejecuta el comando

sfc /scannowen el símbolo del sistema como administrador para reparar archivos del sistema. - Ejecuta el solucionador de problemas de Windows Update (

Configuración > Sistema > Solucionar problemas > Otros solucionadores de problemas). - Asegúrate de tener espacio suficiente en disco.

- Desinstala antivirus de terceros temporalmente.

Debe estar conectado para enviar un comentario.