ColorDec es un interesantismo proyecto que representará al colegio Lope de Vega de 3ª de el ESO para el concurso RetoTech que organiza ENDESA creado por Esther Scott, Irene Yebra, Irene Jimenez,Lucia Gomez y Paula Vidal , con el propósito de ayudar a personas con discapacidad visual para mejorar su percepción de los colores, gracias a un hardware de bajo coste basado en Arduino y una aplicación móvil que ellas mismas han escrito usando el Mit App Inventor, una herramienta de la que por cierto hemos hablado en numerosas ocasiones en este blog .

El proyecto tiene pues su base en un Arduino Nano, al que le han acoplado un modulo bluetooth para el envío de datos a un smartphone mediante los pines 9 (Rxd) , 8(Txd) para los datos vía serie, así como VCC y gnd para la alimentación desde Arduino al propio modulo Bluetooth.

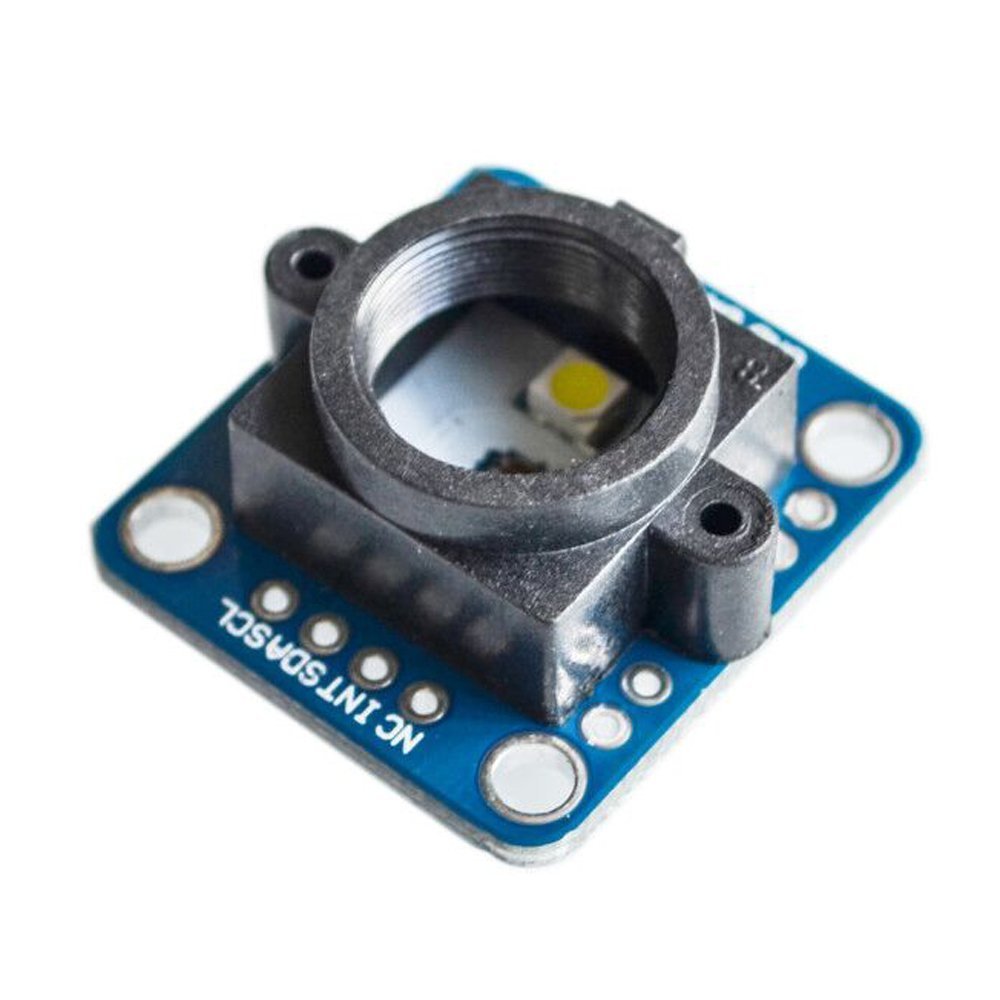

Para el reconocimiento de colores cuenta con un sensor especializado como es el GY33 ( unos 15€ en Amazon) el cual conectan al propio Arduino via I2C por los pines A4,A5 alimentándose desde el propio Arduino desde los pines 5v y GND.

El GY-33 es un modulo de reconocimiento de color de bajo costo que puede alimentarse entre 3-5 V, con bajo consumo de energía, de tamaño pequeño y facilidad de instalación.

Su principio de funcionamiento radica en que la iluminación de la irradiación de luz LED debe medirse hacia el objeto de modo que la luz de retorno es detectada por los filtros de valores RGB y el propio modulo identifica los colores según los valores RGB.

Este módulo, soporta dos maneras de envió de datos:

- Via serie, es decir mediante UART en serie (nivel TTL) configurando la conexión a 9600bps y 115200bps siendo la velocidad en baudios del puerto en serie configurable.

- I2C (mediante 2 líneas) que es el que han empleado en este circuito mediante lso pnes A4 y A5 .

El modulo puede hacer un reconocimiento simple de 7 colores y no es necesario calcular el valor RGB o se puede gestionar el dato de una manera compleja como vamos a ver.

Se complementa el circuito final con un pulsador(pin2) con su respectiva resistencia para evitar rebotes y la alimentación de todo el conjunto por un pila de 9v desde los pines VIN y GND de Arduino.

El diagrama final lo podemos ver en la imagen de mas abajo:

El dispositivo esta pensado para ser portátil de modo que sujetándolo con una mano se apoya en el objeto del que se desea conocer el color , se pulsa el botón para que este lo transmita (tras convertirlo de RBG a HSV) por bluetooth al teléfono móvil del usuario, desde donde una APP lo reproduce hablando en inglés o castellano.

En cuanto al software para este proyecto ha sido realizado utilizando el IDE de Arduino para programar un Arduino Nano, al que se le ha conectado un módulo Bluetooth, un Pulsador y un módulo GY-33 para el reconocimiento de color lo cual es tarea del firmware de Arduino gestionarlo

El programa del Arduino, en su inicialización realiza un balance de blanco, y después espera a que se pulse el pulsador para leer el color, convertirlo a HSV y enviarlo por Bluetooth al móvil.

El código provisional para el firmware de Arduino que aun esta es proceso de mejora nos lo comparten en estas lineas:

Ya desde el teléfono, se conecta al Arduino por Bluetooth, se cargan dos arrays con los datos de dos ficheros CSV, uno con los códigos RGB de los colores y otro con los nombre de esos colores .

Se busca el color en el array y si se encuentra ese será el que el teléfono lea en voz alta.

Sino se encuentra entre los más de 600 códigos RGB, se usa el código en HVS para construir una frase que describe como es el color y se envía al sistema de síntesis de voz del teléfono.

La conversión a HVS han tenido que hacerla al no poder ordenar los códigos RGB para poder situarse sobre el color más cercano al leído.

Amablemente nos han compartido sin código escrito con el MIt App Inventor para desplegarlo en un terminal Android

Es sin duda un sistema de mínimo coste que puede ser de muchísima ayuda para identificar los colores para personas con deficiencias visuales, así que le deseamos desde este blog toda la suerte posible . El premio es una plaza para cada una de las cinco en un campamento de verano donde seguirán aprendiendo robótica y programación , así que queridos lectores porfavor si os parece interesante todo el esfuerzo de esta chicas y merece vuestra confianza, esta es la dirección para votar su proyecto:

https://pr.easypromosapp.com/voteme/826101/630232517

Personalmente ya he votado porque me ha parecido impresionante el trabajo realizado , así que desde esta lineas les deseamos toda la suerte en este concurso y ojala puedan seguir aprendiendo y perfeccionando sus conocimientos tecnicos de modo que puedan seguir ayudando a construir un mundo mucho mejor gracias al uso de la tecnología y su ingenio

Debe estar conectado para enviar un comentario.