Una instalación local de WordPress puede ser útil por varias razones:

- Desarrollo de Temas y Plugins: Proporciona un entorno seguro y aislado para desarrollar y probar temas y plugins de WordPress antes de implementarlos en un sitio en vivo. Esto permite a los desarrolladores experimentar sin riesgo de afectar un sitio web en producción.

- Pruebas de Actualizaciones: Los desarrolladores y administradores pueden probar nuevas versiones de WordPress, temas y plugins sin preocuparse por posibles problemas de compatibilidad o errores que puedan surgir en un sitio en vivo.

- Aprendizaje y Práctica: Permite a los principiantes aprender a usar WordPress sin la necesidad de un servidor en vivo. Pueden experimentar con la plataforma, probar diferentes configuraciones y prácticas de diseño sin temor a dañar un sitio real.

- Desarrollo de Contenido: Los creadores de contenido pueden utilizar una instalación local para escribir y diseñar nuevas publicaciones, páginas y contenido multimedia antes de publicarlos en su sitio en vivo.

- Pruebas de Seguridad: Los administradores de sitios pueden realizar pruebas de seguridad y análisis de vulnerabilidades en una instalación local sin poner en riesgo un sitio real.

- Desarrollo Multisitio: Para aquellos que desean configurar una red multisitio de WordPress, una instalación local ofrece un entorno controlado para desarrollar y probar esta funcionalidad antes de implementarla en un entorno de producción.

Para instalar WordPress, necesitará algunos requisitos previos y seguir algunos pasos básicos. Aquí hay una guía general sobre qué necesita y cómo instalar WordPress:

- Servidor Web: La mayoría de los hosts de alojamiento web proporcionan servidores web como Apache o Nginx que son compatibles con WordPress.

- Base de Datos MySQL o MariaDB: WordPress utiliza una base de datos para almacenar su contenido y configuración. Asegúrese de tener acceso a una base de datos MySQL o MariaDB en tu servidor.

- PHP: WordPress está escrito en PHP, por lo que necesitará una versión compatible de PHP instalada en su servidor.

- Descargue WordPress: Visite el sitio web oficial de WordPress (wordpress.org) y descargue la última versión de WordPress.

- Cree una Base de Datos: Utilizando herramientas como phpMyAdmin o a través de la línea de comandos, cree una base de datos MySQL o MariaDB para tu instalación de WordPress.

- Configure wp-config.php: Renombre el archivo

wp-config-sample.phpque viene con la descarga de WordPress awp-config.php. Edite este archivo con la información de su base de datos, como nombre de la base de datos, nombre de usuario y contraseña. - Suba WordPress a su Servidor: Suba los archivos de WordPress a su servidor web utilizando FTP, SFTP o el administrador de archivos proporcionado por tu proveedor de alojamiento. En caso de instalación local lógicamente esto será mucho mas sencillo y no necesitaremos usar FTP.

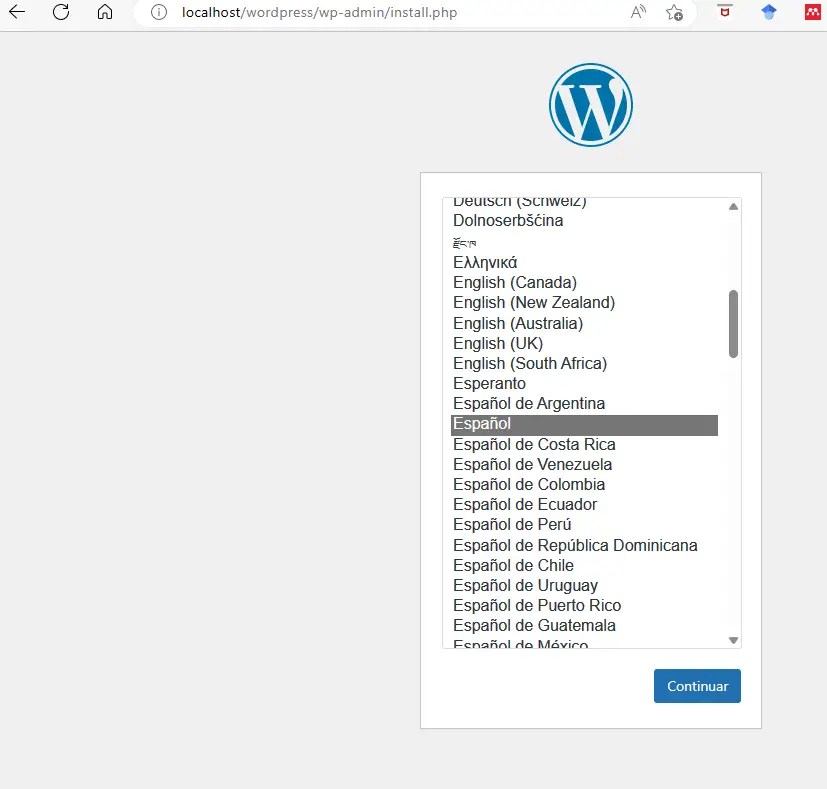

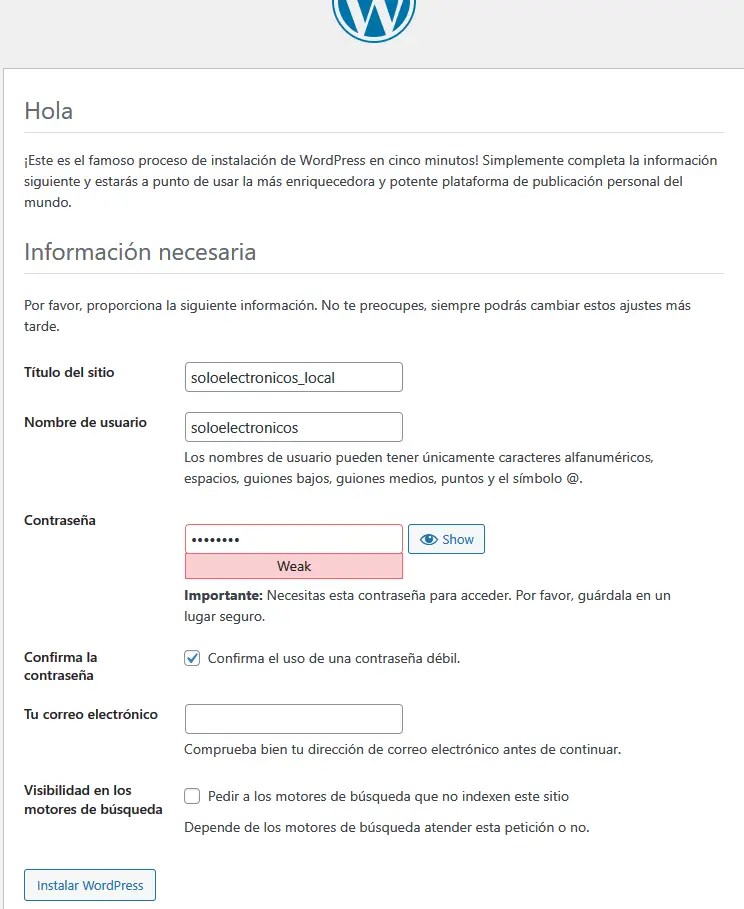

- Instale WordPress: Visita la carpeta donde subio WordPress en su navegador web. Siga las instrucciones de instalación de WordPress, que incluyen configurar el título de tu sitio, crear un nombre de usuario y contraseña para el administrador, y proporcionar la información de la base de datos.

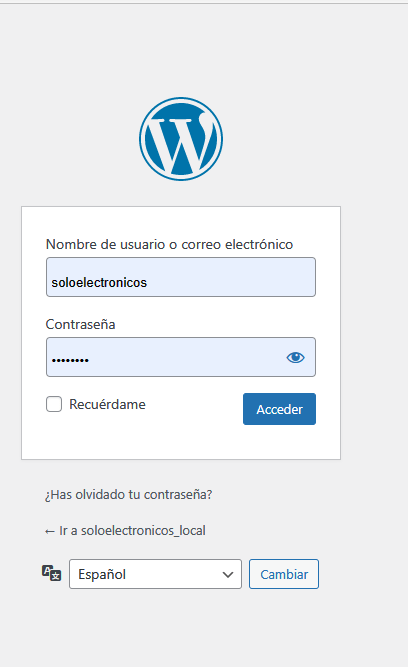

- Acceda a su Sitio de WordPress: Una vez completada la instalación, podrá acceder al panel de administración de WordPress utilizando la URL proporcionada durante la instalación (generalmente

/wp-admin).

Para recrear su blog de WordPress.com en su máquina con Windows 11 o simplemente crear un blog nuevo puede seguir estos pasos que vamos a ver mas en detalle, que como vamos a ver con XAMPP se simplifica notablemente:

PASO 1

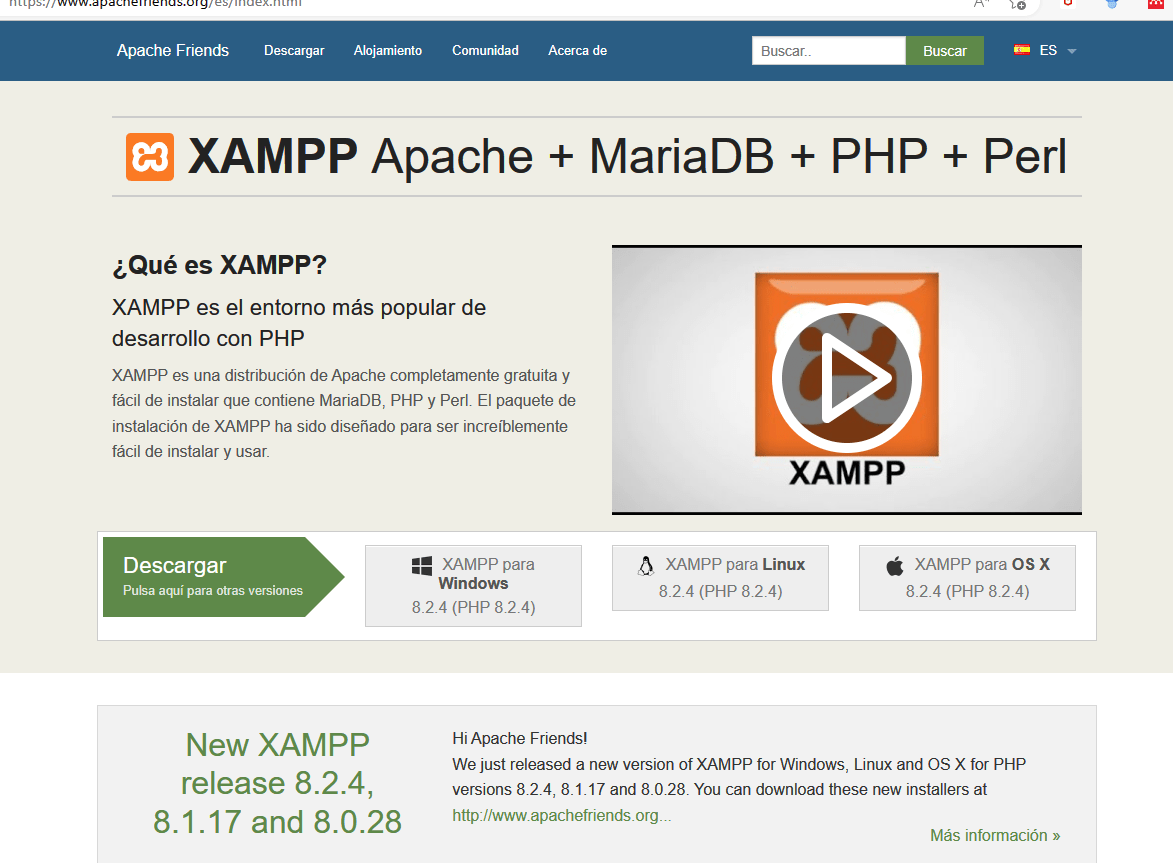

Descargue e instale un servidor local como XAMPP (o WAMP en tu máquina) que puede encontrar estos programas de forma gratuita en línea.

XAMPP es un paquete de software libre, que consiste principalmente en el sistema de gestión de bases de datos MySQL, el servidor web Apache y los intérpretes para lenguajes de script PHP y Perl. El nombre es en realidad un acrónimo: X, Apache, MariaDB/MySQL.

Vaya al sitio de descarga https://www.apachefriends.org/es/index.html, así que descargaremos el fichero correspondiente a nuestro sistema operativo ( en nuestro caso Windows 64 bits) y tras esto procederemos a ejecutar el fichero de instalación.

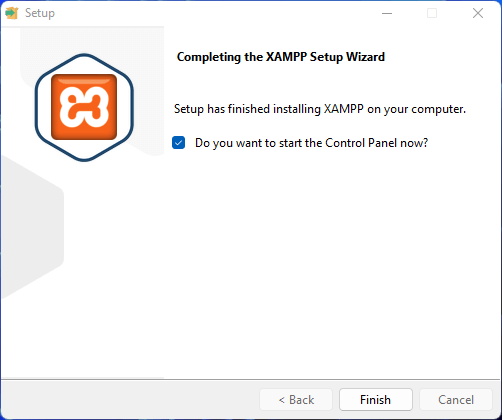

Al terminar de la instalación nos aparece una lista de servicios disponible que podemos arrancar /parar gestionar o ver los logs de eventos.

Para una instalación «normal» nos puede bastar arrancar solo el servidor web( Apache) , la BBDD ( MySql).

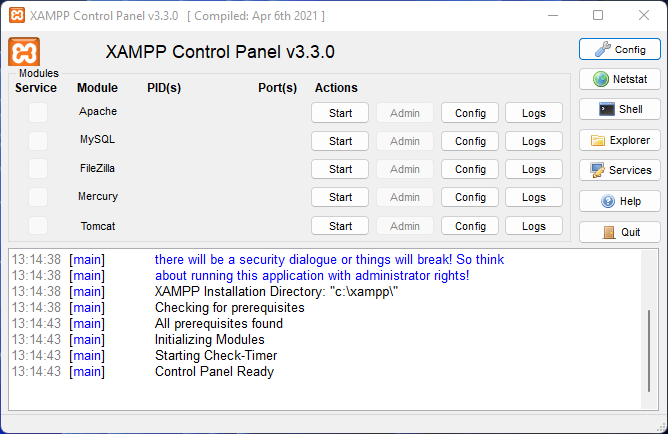

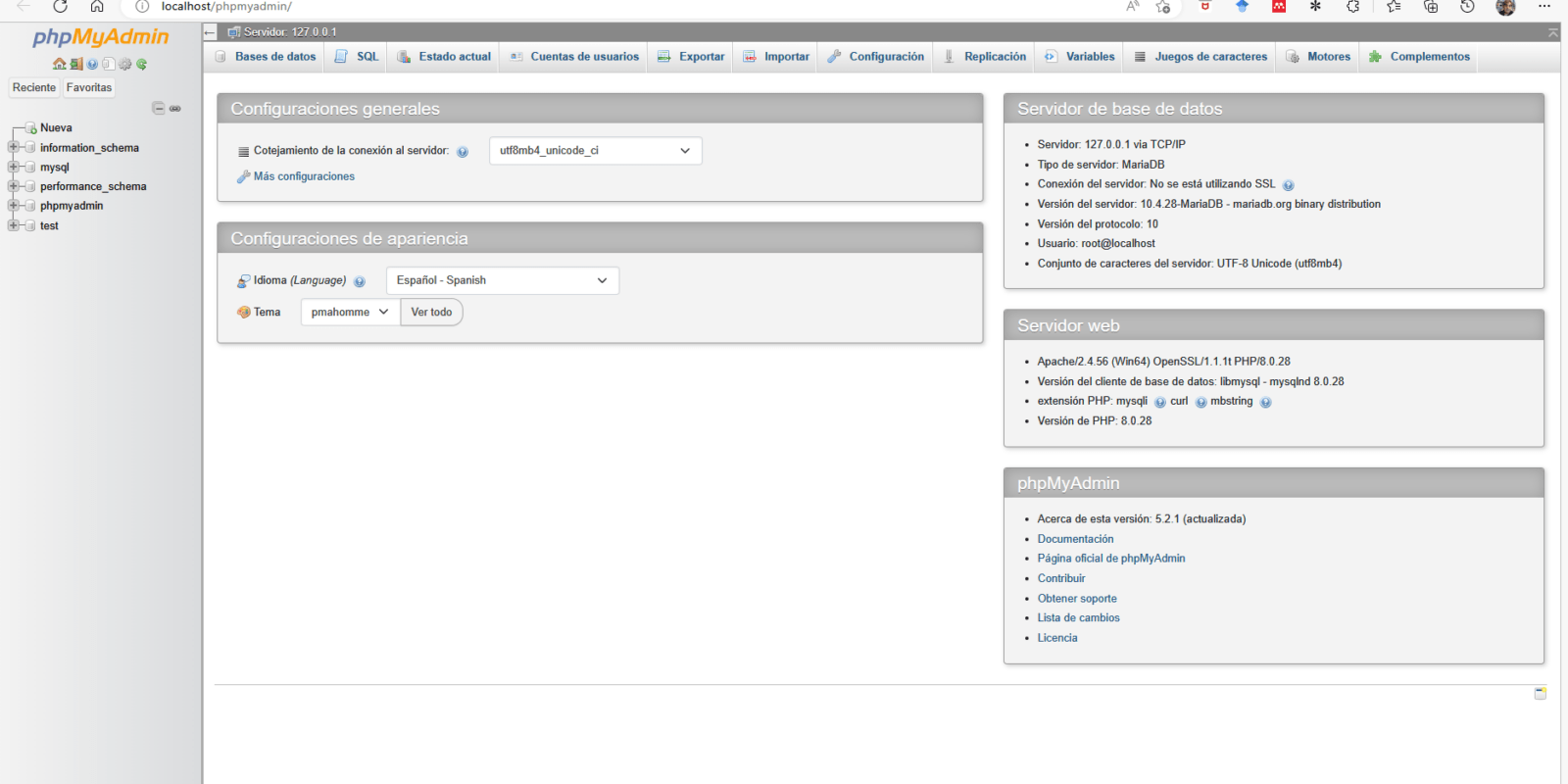

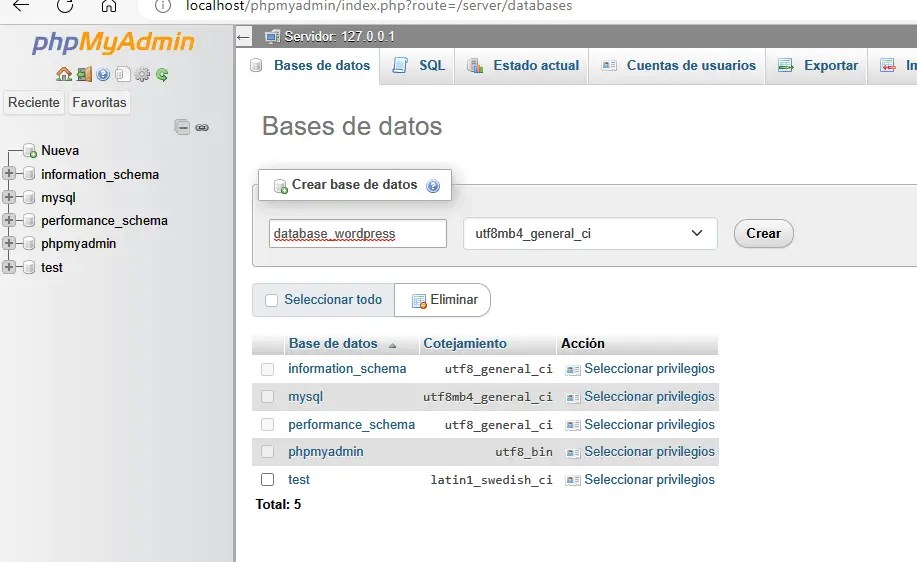

Arrancaremos la BBDD desde el botón Start de Xampp y crearemos una base de datos MySQL para el nuevo sitio web local, para lo cual podemos hacerlo a través de la interfaz de administración de XAMPP o WAMP, pero para poder acceder a la pagina de administración de MySql tendremos que arrancar primero el servicio Apache ( accesible desde http://localhost/phpmyadmin/ )

Pulsando en admin podremos gestionar asimismo el servidor MySQL.

PASO 2

Antes de continuar debemos Instalar WordPress en nuestro servidor local. Puede descargar la última versión de WordPress desde su sitio web oficial. No confundir con wordpress desktop.

Lo descargamos desde si sitio https://es.wordpress.org/download/

PASO 3

Asimismo también descargaremos la exportación de nuestro sitio web en formato XML desde WordPress.com (podemos hacer esto a través de la sección de exportación en la herramienta de administración de tu sitio web en WordPress.com).

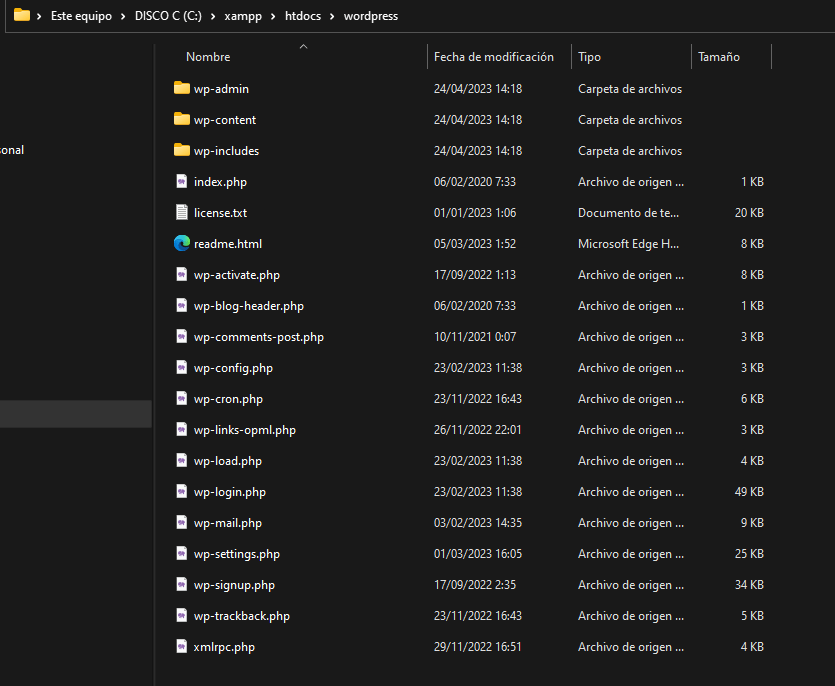

Descomprima el archivo de WordPress que acaba de descargar y copie los archivos en la carpeta raíz de su servidor local.

Extraiga los archivos de WordPress en la carpeta de documentos del servidor web que instaló en el paso 1. En nuestro caso, como estamos usando XAMPP en Windows, deberemos extraer los archivos en la carpeta «htdocs» en la ruta «C:\xampp\htdocs»

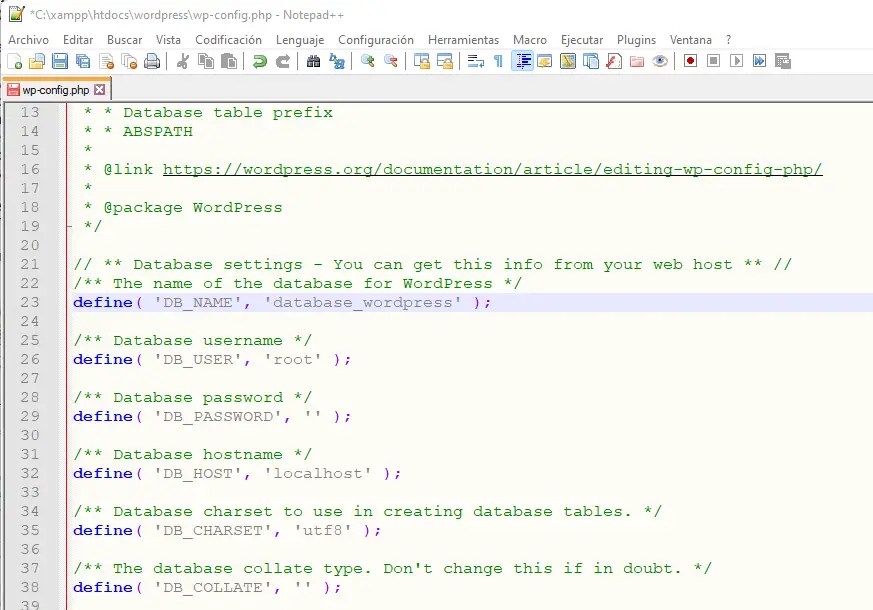

Abra el archivo «wp-config-sample.php» y cambia el nombre a «wp-config.php»

Abra su navegador web y escriba la dirección «localhost/nombre_de_la_carpeta_de_wordpress» en la barra de direcciones. El nombre de la carpeta de WordPress es el que le haya dado en el paso anterior ( wordpress en nuestro caso)

PASO 4

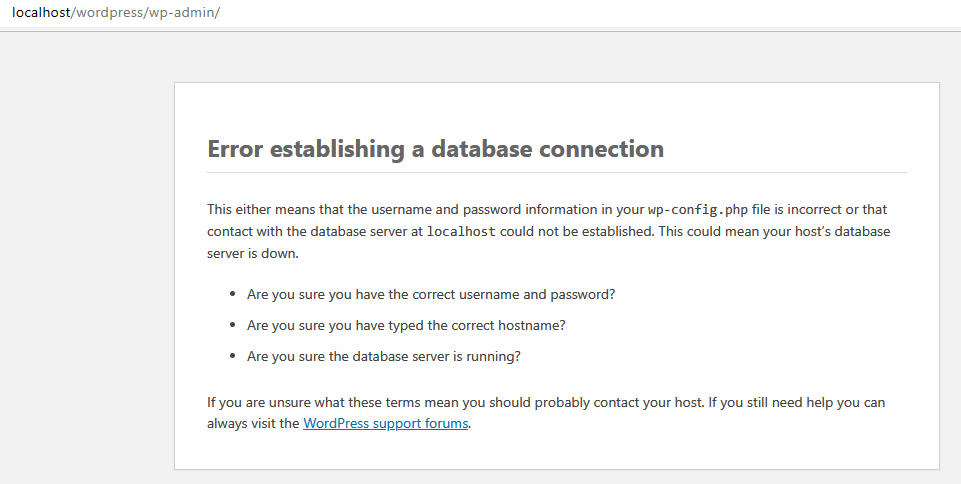

Para hacer la instalación de WordPress en un servidor local usando MySQL, necesitaremoss las siguientes credenciales de MySQL:

- Nombre de usuario de MySQL: Este es el nombre de usuario que usas para acceder a tu base de datos de MySQL. Por lo general, el nombre de usuario predeterminado es «root».

- Contraseña de MySQL: Esta es la contraseña que usas para acceder a tu base de datos de MySQL. Si no has creado una contraseña para el usuario «root», deje este campo en blanco.

- Nombre de la base de datos de MySQL: Este es el nombre de la base de datos que va a usa para WordPress. Puedes darle el nombre que quieras, pero el nombre debe existir en MySQL.

- Host de MySQL: Este es el servidor de MySQL que estás usando. Si estás haciendo la instalación en local, el host será «localhost«.

Después de obtener estas credenciales de MySQL, deberás ingresarlas en el archivo «wp-config.php» de WordPress para que WordPress pueda conectarse a la base de datos y realizar la instalación.

Recuerde que también deberá configurar el idioma, la clave secreta de WordPress y otros detalles en el mismo archivo antes de iniciar la instalación.

Acceda a su servidor local a través de tu navegador web y siga las instrucciones en pantalla para configurar su instalación de WordPress. Durante la configuración, deberá proporcionar la información de la base de datos que creo anteriormente.

Un paso importante es la configuración del titulo del sitio y el nombre de usuario y la contraseña para acceder al panel de administración.

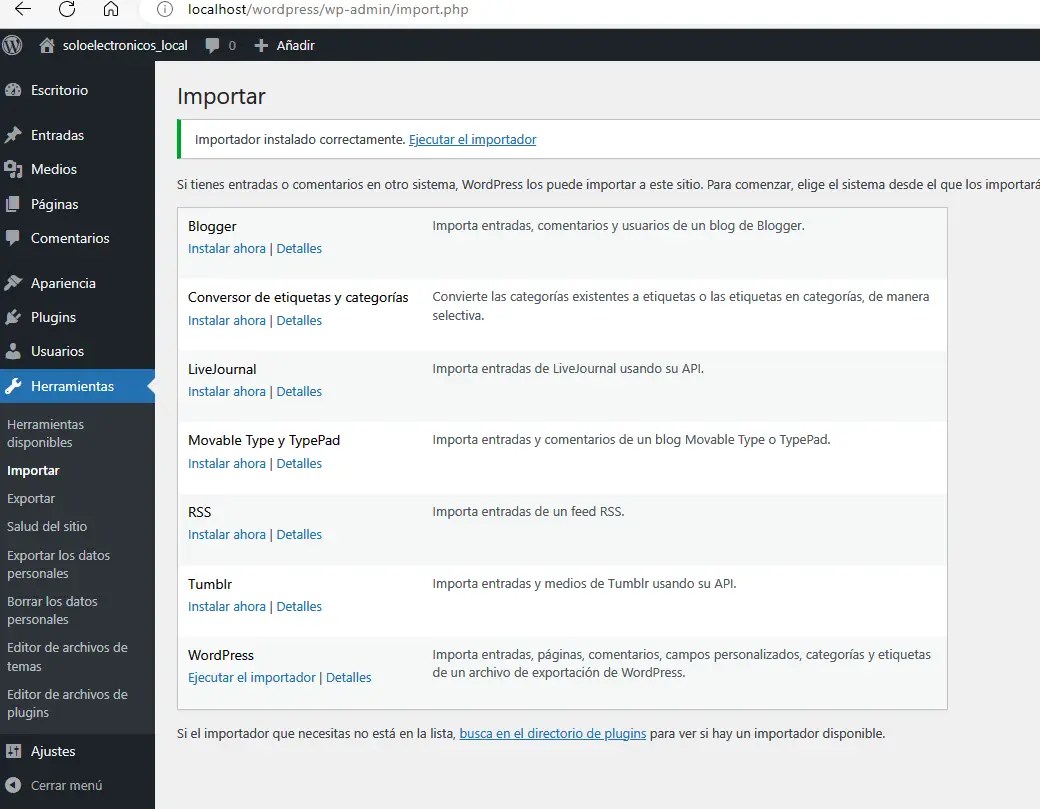

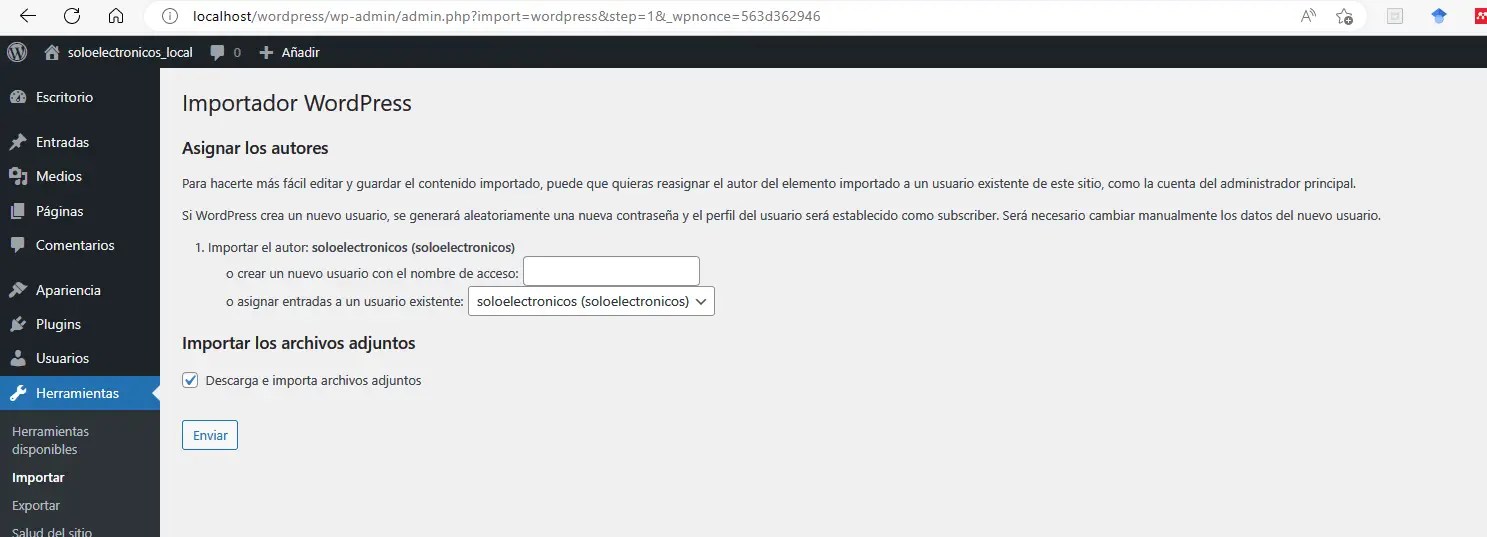

Una vez que haya configurado WordPress en su servidor local, puede importar el archivo XML que descargó de WordPress.com. Para hacer esto, vaya a la sección de importación en la herramienta de administración de WordPress y seleccione el archivo XML que descargó.

Asegúrese de marcar la opción para importar la biblioteca de medios también.

Después de que la importación haya finalizado, debería tener una versión local de su sitio web de WordPress.com en su máquina con Windows 11.

No olvide por cierto instalar el mismo tema que tenia en su blog original para que la copia sea exacta ( obviamente mas adelante puede probar otros temas si le interesa probarlos antes de hacerlo con su blog).

Asimismo no esta de mas revisar la sección de ajustes (generales , escritura, lectura, etc.) . Mención ESPECIAL tiene la sección de Enlaces permanentes , que de NO mantenerlo del mismo modo impedirá acceder a su entradas

Una vez hecho esto ya puede acceder a él a través de su navegador web y trabajar en él como lo haría en WordPress.com.

Espero que estos pasos le sean útiles para recrear tu sitio web de WordPress.com en su máquina con Windows 11. ¡Buena suerte!

Debe estar conectado para enviar un comentario.