Con más de ocho millones de unidades vendidas , incluyendo tres millones de unidades de Raspberry Pi 2 , nadie duda que Raspberry es una plataforma muy exitosa , tanto que de hecho la Fundación Raspberry Pi ha crecido de un puñado de voluntarios a llegar a más de sesenta empleados a tiempo completo, ! e incluso han enviado un Frambuesa Pi a la Estación Espacial Internacional !

Desde hace unos meses por fin ya esta disponible en Amazon la nueva Raspberry Pi 3 Modelo B ,la última placa de la familia de Raspberry Pi ,una placa 10 veces más potente que la original (es decir la primera versión) , donde lo mas destacable es que se ha añadido conectividad inalámbrica integrada tanto por wifi (soportando los estándares 802.11 b/g/n) , como por Bluetooth ( versión 4.1).

Hablando de conectividad ,la nueva placa incorpora el chip BCM2837 junto el chip inalámbrico «combo» BCM43438 . Gracias a esta combinación de CI, ha permitido adaptar la funcionalidad inalámbrica en casi el mismo factor de forma de los modelos anteriores como el Raspberry Pi Modelo B + 1 y Raspberry Pi 2 Modelo B. De hecho el único cambio es que la posición de los LEDs los han trasladado al otro lado de la ranura de la tarjeta SD para hacer espacio para la antena.

Ademas,para Raspberry Pi 3 Modelo B , Broadcom ha apoyado un nuevo SoC, el BCM2837, el cual conserva la misma arquitectura básica que sus predecesores BCM2835 y BCM2836, por lo que todos los proyectos y tutoriales que se basan en este hardware de la Raspberry Pi continuarán funcionando.

Comparable con el modelo anterior (Raspberry pi 2 model b ) , esta nueva placa destaca por usar un procesador de 64 bits : un ARM Cortex-A53 de cuatro núcleos a una velocidad de reloj de 1,2 GHz en lugar de un Quad-Core Cortex A7 de 32 bits a 900 MHz de su antecesor ( Raspberry Pi 2 modelo B), por lo que vemos que el cambio de procesador ha sido espectacular no solo por la velocidad de reloj superior (de 900 Mhz a 1,2 GHz) , sino básicamente por el cambio de arquitectura también ARM ,pero de 64 bits en lugar de la antigua de 32 bits .

La combinación final de un aumento del 33% en la velocidad de reloj con varias mejoras en la arquitectura, ha permitido proporcionar un aumento del 50-60% en el rendimiento en el modo de 32 bits frente a la Raspberry Pi 2, o aproximadamente un factor de diez sobre el original Raspberry Pi.

Sobre la memoria RAM cuenta con 1GB LPDDR2 ( la versión anterior también contaba con 1GB) y a nivel de gráficos también han mejorado pues cuenta con un Dual Core VideoCore IV ® Multimedia Co-procesador.

Sobre los conexiones disponibles sin embargo , no ha cambiado sustancialmente , contando como en la versión anterior con las siguientes posibilidades:

- 4 Puertos USB 2.0

- Puerto de GPIO de 40 pin,

- Salida HDMI rev 1.3 y 1.4

- Toma Ethernet

- Jack de audio de 2 1/2″ ,

- Interfaz de cámara (CSI)

- Interfaz de Pantalla (DSI)

- Lector micro SD

Todos los conectores anteriores están en el mismo lugar y tienen la misma funcionalidad, y para alimentar la placa todavía se puede usar un adaptador de alimentación de 5V micro-USB, pero en esta ocasión, están recomendando un adaptador 2.5A por si desea conectar dispositivos USB que consumen mucha energía de la Raspberry Pi.

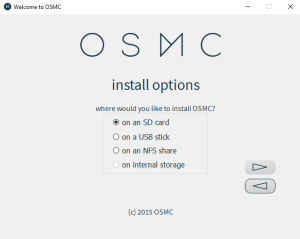

Usted necesitará una imagen reciente NOOBS o de Raspbian que puede descargar desde la pagina de descargas . En el lanzamiento, están utilizando el mismo espacio de usuario de 32 bits Raspbian usada en otros dispositivos Raspberry Pi; pero en los próximos meses van a trabajar el movimiento al modo de 64 bits.

La nueva placa no es solo un dispositivo estupendo para programar sino que también es ideal para jugar y experimentar incluso para sus futuros proyectos de IoT.

Algunas dudas

¿Está versión descontinúa modelos anteriores Frambuesa Pi? No sus fundadores tienen gran cantidad de clientes industriales que querrán seguir con Raspberry Pi 1 o 2 por el momento así qeu van a mantener la construcción de estos modelos durante el tiempo que haya demanda.

¿Qué pasa con el Modelo A +? Modelo A + sigue siendo el nivel de entrada económico de Raspberry Pi por el momento.Su fundadores esperan producir una 3 Raspberry Pi Modelo A, con el factor de A + durante el 2016.

¿Qué pasa con el módulo de cómputo? Esperan introducir un módulo de cómputo basado en BCM2837 3 en los próximos meses.

¿Todavía usa VideoCore?Sí. VideoCore IV 3D es el único núcleo de gráficos de 3D para SoC basados en ARM documentado públicamente, y quieren hacer una Rspberry Pi más abierta con el tiempo. BCM2837 ejecuta la mayor parte del subsistema VideoCore IV a 400MHz y el núcleo 3D a 300 MHz (250 MHz frente a los dispositivos anteriores).

¿De dónde viene la cifra «10 veces más rendimiento» viene?10x es una figura típica de un punto de referencia de la CPU multi-hilo como SysBench. Las aplicaciones del mundo real verán un aumento de rendimiento de entre 2,5x (para aplicaciones de un solo subproceso) y> 20 veces (para los códecs de vídeo NEON habilitado).

Sin duda el producto es muy recomendable para muchas aplicaciones, incluso supliendo funciones de automatización que antes requerían un ordenador de sobremesa o por ejemplo como potente centro multimedia

Por cierto, si le interesa este modelo, por menos de 50€ con gastos de envío incluido puede conseguirlo en Amazon

Debe estar conectado para enviar un comentario.